Rust Magazine 2022 第一季

作者: 张汉东

发刊通告

Rust Magazine 于 2021 年 1 月创刊,其初衷是想成为国内 Rust 用户分享自己学习和使用 Rust 的经验平台。然而事与愿违,虽然 2021 年期刊完整输出了,也受不少 Rust 社区朋友的喜欢,但是其实它并没有达成既定的目标。

所以,2022年 《Rust Magazine》 将重新定位:Rust 生态观察者。

《Rust Magazine》将按季度发布,分类记录 Rust 生态中的一举一动。Rust 用户可以在这里找到不错的学习资源、项目实践的灵感、有趣的开源项目,并且可以及时了解 Rust 官方动态、社区事件等。

当然,也继续接受投稿。投稿更加简单,只需要找到每个季度的 contribute 目录直接发 PR 即可,内容只限于 Rust,只要你觉得你写的内容对大家有帮助,就值得分享。

Rust 生态第一季回顾

2022 年,在整个世界都还在意犹未尽地总结 2021 年有什么收获且对新的一年做出展望的时候,俄乌战争爆发了。这场战争,不仅仅波及了俄乌两国的人民,还聚焦了整个世界的关注,包括我们 Rust 社区。

Rust 官方在发布 1.59 稳定版的博客中,写道:

Today's release falls on the day in which the world's attention is captured by the sudden invasion of Ukraine by Putin's forces. Before going into the details of the new Rust release, we'd like to state that we stand in solidarity with the people of Ukraine and express our support for all people affected by this conflict.

中文翻译:

今天的发布正值普京的部队突然入侵乌克兰,吸引了全世界的注意力。在详细介绍新的Rust版本之前,我们要声明,我们声援乌克兰人民,并对所有受这场冲突影响的人表示支持。

因为国内外政治风向不同,这件事引起国内社区的热议,包括其他技术社区,尤其是前端社区,甚至还出现了去 react 官网留言辱骂的行为。个人认为没有必要做出这么极端的行为。 Rust 官方在很早之前就说过,技术是离不开政治的。

那么,我们应该如何看待 Rust 官方这种行为呢?

- 从人道主义角度来说,支持乌克兰人民是必须的。但我们不仅仅支持乌克兰人民,我们也支持世界上任何一个受战争迫害国家的人民。

- Rust 官方有官方自己的立场,我们也无权干涉。

- 我们可以不在技术社区谈论政治,但作为世界公民有义务关注政治形势,因为我们每个人都不可能独善其身。

- 虽然技术离不开政治,但是在开源社区,至少还有开源行为规范,我们应该尽力遵守行为规范,共同维护和谐交流的社区。

- 无论是技术上还是政治觉悟上,要努力提升自己,不随大流,不被当枪使,不要人云亦云,有自己的独立思考。

也因为此次事件,很多人关心,是不是 Rust 语言也会受到影响呢?

其实没必要惊慌,真实的开源世界是很复杂的。GitHub 作为美国的公司,肯定要遵循美国的法律。Rust 在 GitHub 上开源,但 Rust 是全球的,代码是完全可以 fork 到其他任何地方的。

美国向这个世界贡献了那么多好的技术、理念、文化,因此才能成为世界的领导者。而中国如果想要崛起,想要成为多极世界中的一极,同样需要贡献足够多的“礼物”。 - 开源社庄表伟 《面对真实的开源世界,丢掉幻想,但也不必恐慌》

所以,如果我们需要 Rust,那么我们就需要给 Rust 做更多贡献。

在 2022 年第一季度,Rust 生态整体来说平稳发展。但也有一些值得关注的点:

- Rust 语言团队 2024 Roadmap 已经发布。Rust 语言团队将聚焦于以多种不同的方式扩展授权,让越来越多的人受益,也就是说,让 Rust 广泛应用,将专注于三个主要主题来完成这个目标:拉平学习曲线、扩展生态系统、扩展项目。

- WebAssembly 发展初露苗头。DeisLabs 团队中九人集体离职成立初创公司 Fermyon,并推出WebAssembly 框架 spin。DeisLabs 属于微软,他们的开源项目基本都是围绕 Rust 和 WebAssembly 在云原生的一些应用,有好几个 CNCF 项目。现在突然九人一起离职创建新公司,并专注于 WebAssembly,那证明他们一定看到了 WebAssembly 的广泛前景。

- Rust 生态中终端应用不断涌现出优秀应用。说明目前在终端应用领域,Rust 是非常成熟了。

- Rust 跨平台开发已凸显出了它的优势,尤其在 GUI 领域。

- Rust 在区块链领域的应用也非常值得关注。

- Rust 安全依然不容忽视,从 RustSec 和 GitHub 公告中看出,Rust 中内存安全和线程安全漏洞依然多于其他漏洞。

- Rust 在生物信息科技领域也有好几个开源应用,比想象中要多,主要集中在基因测序方向上。

- 有人开始用 Rust 来重写经典软件了,比如 Fornjot 要创建下一代 Code-CAD 。

- 在学术领域,研究 Rust 和 WebAssembly 的论文越来越多了。

还有很多内容,希望大家可以从本刊提供的信息中受益!

资源

官方动态

Rust 语言团队 2024 Roadmap 发布

Rust 语言团队将聚焦于以多种不同的方式扩展授权,让越来越多的人受益,也就是说,让 Rust 广泛应用。将专注于三个主要主题来完成这个目标:拉平学习曲线、扩展生态系统、扩展项目。

https://blog.rust-lang.org/inside-rust/2022/04/04/lang-roadmap-2024.html

2021 Rust调研

2021年12月时,Rust项目组对于Rust发布了一次调研。详细调研结果可见《Rust Survey 2021 Results》,部分结果概括如下:

- 90%的参与者目前正在使用Rust;

- 78%的参与者使用英文填写问卷;

- 23%的参与者主要使用Rust编程,59%的参与者至少偶尔在工作中使用Rust;

- 关于为何在工作中使用Rust,96%的参与者认同Rust的正确性,92%的参与者认同性能,89%的参与者认同安全性。

Rust 1.59.0

Rust 1.59.0版本发布于2022年2月24日。

新的稳定版本内容大致如下:

-

编写汇编代码时,可以将变量名写到花括号内了,形同

format!更新后的使用方式。例如,现在支持这种写法:#![allow(unused)] fn main() { use std::arch::asm; // Multiply x by 6 using shifts and adds let mut x: u64 = 4; unsafe { asm!( "mov {tmp}, {x}", "shl {tmp}, 1", "shl {x}, 2", "add {x}, {tmp}", x = inout(reg) x, tmp = out(reg) _, ); } assert_eq!(x, 4 * 6); }- 支持的汇编语言为:x86,x86-64,ARM,AArch64,RISC-V

-

支持包含未初始化变量的元组、数组、或结构体语法作为赋值命令的左值,并拆分右值的元组、数组、结构体,为左值中的变量一一赋值。例如:

#![allow(unused)] fn main() { let (a, b, c, d, e); (a, b) = (1, 2); [c, .., d, _] = [1, 2, 3, 4, 5]; Struct { e, .. } = Struct { e: 5, f: 3 }; assert_eq!([1, 2, 1, 4, 5], [a, b, c, d, e]); // 但是不可以这样写 // let mut (a, b); // (a, b) = (1, 2); // `+=` 的写法是不允许的 // (a, b) += (1, 2); } -

常量泛型可以指定默认值了,同时不再要求常量泛型必须写在一般泛型之后,例如:

#![allow(unused)] fn main() { struct ArrayStorage<T, const N: usize = 2> { arr: [T; N], } // 指定默认值 impl<T> ArrayStorage<T> { fn new(a: T, b: T) -> ArrayStorage<T> { ArrayStorage { arr: [a, b], } } } // 不再要求常量泛型必须写在一般泛型之后 fn cartesian_product< T, const N: usize, U, const M: usize, V, F >(a: [T; N], b: [U; M], f: F) -> [[V; N]; M] where F: FnMut(&T, &U) -> V { // ... } } -

优化了 Rust 编译器报错,当后续更新版本不兼容当前代码时,Cargo 产生告警并提前预知用户。可以通过

cargo report指令检查新版本是否兼容当前代码。 -

可以通过设置

Cargo.toml而非手动的方式去除不需要的二进制符号了。例如:[profile.release] # 对于 release 版本,去除所有的 debug 符号 strip = "debuginfo"目前可选选项如下:

选项 释义 strip = "none" (default) / strip = false 不去除任何符号 strip = "debuginfo" 去除 debug 符号以及关于行号的 debug 信息相关的二进制内容 strip = "symbols" / strip = true 去除所有不必要符号 更详细的说明可见 Cargo Book #Strip。

-

增量编译默认值设置为1,这样可以减轻编译时可能出现的反序列化错误的影响。增量编译的详细解释可见本篇 #Rust与编译速度。

-

将一些功能引入Stable版本。

Rust 1.58

通常来说,Rust每隔6个星期会发布一次新版本。Rust 1.58.0版本发布于2022年1月13日,主要针对格式化字符串、Windows可执行文件搜索、以及对于一些功能的稳定化;而Rust 1.58.1版本发布于2022年1月20日,主要是修复了1.58.0版本中的Bug,保证系统安全。升级到新版本的方法可参考《This Week in Rust #404:Rust 2021 与 周期性服务发现》"如何升级到Rust新版本"部分。

新的稳定版本内容大致如下:

-

格式化字符串可以像Python一样,将内容对应变量直接写入

{}符号之中了,例如:#![allow(unused)] fn main() { println!("Hello, {}!", get_person()); // implicit position println!("Hello, {0}!", get_person()); // explicit index println!("Hello, {person}!", person = get_person()); // named let person = get_person(); println!("Hello, {person}!"); // captures the local `person` // 也可以使用变量值 let (width, precision) = get_format(); for (name, score) in get_scores() { println!("{name}: {score:width$.precision$}"); } }唯一的例外是

panic!宏,在2015与2018版本中,panic!("{ident}")的写法依然就产生告警。不过,2021版本维持了格式化字符串的一致性,因此这个特性在2021版本中可以正常使用。 -

对于Windows平台,

std::process::Command指令不再于当前工作文件夹中搜索可执行文件了。此前,由于Win32的CreateProcess接口,当当前程序创造子进程时,Rust会按照 子进程环境路径 - 应用文件夹 - 父进程文件夹 - 32位/16位系统文件夹 - Windows文件夹 -Path环境变量 的顺序搜索可执行文件。然而,在父进程文件夹搜索可能会导致未知行为,甚至是恶意行为,例如拦截子进程。在搜索父进程文件夹时,ripgrep命令使得攻击者可以通过-z/--search-zip或--pre标识来运行任意程序。具体的报告可见CVE。因此,Rust不再搜索父进程文件夹,同时不再搜索旧系统遗留的16位系统文件夹。 -

修复调用

std::fs::remove_dir_all时会产生竞争场景的漏洞。具体的描述可见CVE以及Rust官网发布的推文,概括一下即是,对于攻击者无权限删除的某一文件夹\sensitive,攻击者可以利用remove_dir_all,从有权限的文件夹\temp创建引用链接至\sensitive,然后在有权限应用中调用remove_dir_all,从而删除本无权限操作的文件夹\sensitive。此前,为了避免这种情况,remove_dir_all只会在判断后删除引用链接,但是在判断和真实删除之间存在时延,导致攻击者可以利用这个时延来替换删除目标,导致该漏洞。 -

对于标准库的一些函数,新增了更多的

#[must-use]属性,这一属性会检测返回值是否被合理处理,例如检查返回Result时,错误是否被处理。 -

将如下功能引入Stable版本:

-

Metadata::is_symlink

-

Path::is_symlink

-

{integer}::saturating_div

-

Option::unwrap_unchecked

-

Result::unwrap_unchecked

-

Result::unwrap_err_unchecked

-

File::options

-

-

将如下功能的返回值更新为

const:-

Duration::new

-

Duration::checked_add

-

Duration::saturating_add

-

Duration::checked_sub

-

Duration::saturating_sub

-

Duration::checked_mul

-

Duration::saturating_mul

-

Duration::checked_div

-

-

对于Rust工具(Clippy, Rustc,Fmt等)进行了更新,具体可见1.58.0以及1.58.1更新日志,在此暂略。

Rust 核心团队有三人宣布退出

-

Steve Klabnik, 将离开核心团队和安全响应工作组。Steve 9年前开始使用 Rust。自 2014 年以来,他是 Rust 编程语言书(the book)的主要作者和核心团队的一员。他一直在运行 @rustlang Twitter 帐户,因此形成了该项目的许多“声音”。Steve 现在可以专注于使用Rust 而不是制作Rust。

-

Florian Gilcher, 正在退出他所有的项目职位。他于 2019 年成为核心团队的观察员,并于 2020 年成为核心团队的正式成员。他还担任过 Rust 基金会董事会的项目总监。在此之前,他自 2015 年以来一直是社区团队的一员。由于他专注于自己的公司并承担其他业务义务,因此他正在为项目中的其他人腾出空间。

-

Pietro Albini, 将离开核心团队,专注于项目的其他部分,包括基础设施团队和安全响应工作组。他于 2019 年底加入核心团队,在成为基础设施团队的联合负责人后不久,但核心团队的工作量让他很难在项目中的其他角色上花费足够的时间。

https://blog.rust-lang.org/2022/01/31/changes-in-the-core-team.html

2022年异步Rust的改进计划

Niko Matsakis 和 Tyler Mandry 代表 Async 工作组发布了一篇文章,阐述了在 2022 年异步 Rust 的改进计划。

Rust 2024 Edition 中使用异步 Rust 的愿景

文章中先假设了一个 Rust 2024 edtion 中实现的异步愿景。

假设在 Rust 2024 Edition 中,你使用异步 Rust 创建一个新项目:使用crates.io 的第三方库 crabbycat来遍历指定 GitHub 仓库的issues列表:

async fn main() {

for await? issue in crabbycat::issues("https://github.com/rust-lang/rust") {

if meets_criteria(&issue) {

println!("{issue:?}");

}

}

}

你的项目似乎工作正常,这个时候有人给你发起 PR: 增加 GitLab 支持。你看到 PR 的代码有下面改进:

// 增加了 Async Trait `IssueProvider` 来抽象 issues 接口

// 兼容 GitHub/Gitlab/Gitothers

trait IssueProvider {

// 这个 issues 方法只需要遍历issues即可

// 所以需要是一个实现AsyncIterator的类型

async fn issues(&mut self, url: &str)

-> impl AsyncIterator<Item = Result<Issue, Err>>;

}

#[derive(Debug)]

struct Issue {

number: usize,

header: String,

assignee: String,

}

// 使用独立的方法打印issues列表

// provider代表issues提供方是GitHub 还是 其他,比如 Gitlab

fn process_issues(provider: &mut dyn IssueProvider) {

for await? issue in provider.issues("https://github.com/rust-lang/rust") {

if meets_criteria(&issue) {

println!("{issue:?}");

}

}

}

你合并了该 PR,一切OK。后面有人想将你的项目移植到 Chartreuse 操作系统,而 Chartreuse 操作系统是基于 Actor 模型的,并且有自己的自定义异步运行时。然而,你其实并不需要关心这些。因为你所有代码都能够无缝地将底层运行时实现切换到 Chartreuse 异步运行时。

在 2022 年将要完成的目标

看得出来,异步 Rust 在 2024 Edition 会更加的完善,使用起来更加方便。但是为了达到这个目标,2022年必须完成一些基础工作,并且可以预料到的是,在这个过程中,异步 Rust 的很多细节会发生大量变化,不出意外的话,生成器的语法应该会备受争议。但我们的整体愿景并不会改变:编写异步 Rust 代码应该像编写同步代码一样简单,除了偶尔出现的async和await关键字。

为此,Async 工作组组织成许多不同的计划,每个计划都在追求愿景的一部分:

- 异步基础计划,由 tmandry领导,聚焦于解决trait中支持

async fn的难题。过去一年的工作:- 协调和支持

GAT和impl Trait计划。 - 起草 RFC #3185,在 trait 中实现静态

async fn,用于支持静态分发,即,可以返回impl Trait。 - 致力于动态分发的设计,Niko 有一系列博文阐述相关内容:Dyn async traits。

- 其他改进,比如Contexts and capabilities in Rust。

- 协调和支持

- 异步迭代器计划,由estebank领导,探索生成器和异步生成器。Estebank 为生成器制作了一个程序宏的原型,并呼吁讨论语法和其他细节。

- 可移植性计划,在nrc的带领下,探索如何让代码在运行时之间轻松移植,从标准化的特征开始,例如

AsyncRead和AsyncWrite。 - 抛光打磨(Polish)计划,由eholk领导,专注于通过较小的变化来提高现有的能力,这些变化共同产生了巨大的影响。比如:

- 工具计划,由pnkfelix领导,致力于支持异步生态系统中那些正在创建有趣的工具来支持异步Rust的开发者们,诸如:

- Michael Woerister正在探索异步crashdump恢复,提供一种机制来恢复和检查基于crashdump的异步Rust程序的状态。

- Eliza Weisman和其他许多人最近宣布了他们0.1版本的

tokio-console(异步Rust程序的诊断和调试工具)。

上面这些计划都可以在 roadmap 中找到。

你如何参与

如果你想参与,最好的路线是先从「打磨抛光计划」开始,在其页面上有"如何帮助 "部分可以参考。

Rust 2024 :敢于要求更多

Rust 语言团队 Leader Niko 在其博文上畅想 Rust 2024 Edition:

- 敢于要求更符合人体工程学、更具表现力的 Rust

- 敢于要求更符合人体工程学、表现力更强的异步Rust

- 敢于要求更符合人体工程学、表现力更强的Unsafe Rust

- 敢于要求从 Rust 的工具中获得更丰富、更具交互性的体验

- 敢于为Unsafe Rust要求更丰富的工具

https://smallcultfollowing.com/babysteps//blog/2022/02/09/dare-to-ask-for-more-rust2024/

Rust 2022 编译器团队的雄心

最近,Rust编译器团队发布了2022年编译器这边要做的一些事情。有三大目标:

- 填充Rust的承诺。性能,可靠性,生产力,这三块都还有补足的空隙;

- 让开发者更开心/舒心。编译速度,运行方式,IDE等;

- 建设更好的贡献工作流。

https://blog.rust-lang.org/inside-rust/2022/02/22/compiler-team-ambitions-2022.html

Cargo Team 新增了新成员

公开宣布,Weihang Lo和Ed Page 加入 Cargo 团队。 与此同时, Alex Crichton 退出 Cargo 团队。Alex 不仅仅是对 Cargo 做了很多贡献,他对 Rust 语言和 Rust 整体生态的贡献也是非常大的。当然, Alex 只是退出 Cargo 团队而已,他还活跃在 wasmtime 等wasm相关生态上。

Weihang Lo 写了一篇文章来纪念这件事:【不必是眾星拱月那個月 也能替世界增添光芒 - 感謝 Alex Crichton 在 Cargo 的長期貢獻,沒有你就沒有現在的 Rust】 。

https://blog.rust-lang.org/inside-rust/2022/03/31/cargo-team-changes.html

rustc编译器现已支持risc-v 的 v指令集和k指令集

现在 Rust标准库上就能做risc-v的内核开发和宿主机(虚拟机)开发了。

具体来说是标准库支持了hypervisor和supervisor的扩展指令。顺便加了个is_riscv_feature_detcted!宏,能在用户态检测riscv扩展是否存在,已经在真机上跑通,合理利用检测宏,能彻底解决“生态碎片”问题。

现在又新增了 V指令集和 K 指令集支持,预计进1.61稳定版rust。

由洛佳提供支持。相关 PR 。

- https://github.com/rust-lang/rust/pull/94995

- https://github.com/rust-lang/rust/pull/92574

- https://github.com/rust-lang/stdarch/pull/1271

nrc 博文| Rust in 2022

Rust 度过了美好的一年。从用户数量、领域多样性、用户承诺、用户规模等方面来看,Rust 现在拥有非常稳固的用户基础。Rust 还拥有大量慷慨的赞助商,无论是通过基金会还是通过公司支付民间费用。社区大多是健康的。在技术方面,Rust 语言、库和工具现在都非常可靠,2021版也顺利发布。

2022 年的 Rust,需要关注些什么呢?

2022 年,要解决的重要问题是项目领导问题和组织债务,并重新关注 Rust 的成熟度。同时,需要继续做下面这些正确的事:

- 维护工作、保持 Rust 运行(错误修复、性能改进、持续支持等),这是一项艰巨且大多乏味的任务。

- 基础设施和版本。

- 开发和维护 Rustup 和 Rustdoc 等基本工具。

- 完善 IDE 支持,这仍旧是 Rust 的一个弱点,但仍在不断改进。

- 研究人体工程学,并打磨语言、库、工具、文档等方面的不足之处

- 在更广泛的社区中使用 Rust 库。

- 审核和其他社区工作。

- 重构、偿还技术债务和核心工具(例如,Chalk)。

- 致力于形式化 Rust、Rust 的内存模型、更好地理解不安全代码、开发 miri 等。

- 改进错误处理库。

- 使用 const 泛型。

https://www.ncameron.org/blog/rust-in-2022-2/

感谢 Joshua Nelson 为 rustdoc 所做的工作

有的人可能知道,jynelson 在成为 rustdoc 团队成员的 2 年后(后来成为联合负责人),最近辞去了该团队的领导职务。他在 rustdoc、docs.rs 和 rustc dev-guide 上的工作(通常是吃力不讨好的)有助于使 rust 成为一种令人惊叹的语言,可以为每个人编写和阅读文档。出于这个原因,我想花几分钟来强调一些我们有时认为理所当然的重大变化。

毫无疑问,最显而易见的功能改进是文档内链接。这允许您像路径导入一样(例如 Foo)编写指向其他位置的链接,轻松无压力。这个概念已经进行了很长时间,但它曾经从根本上被破坏并且在多个方面无法使用。在超过 54 个 PR 中,文档内链接从一个破碎的概念变成了编写 Rust 文档的基本特征。

像所有组成 rust 治理的优秀团队成员一样,Joshua 也一直站在 FCP、PR、问题、RFC 等的前沿。在后台进行的这项繁琐的工作有助于使 rust 成为一种很棒的语言,然而无聊而且常常吃力不讨好。

还有无数的内部修复,以使 rustdoc 更少错误、更快、更清洁等。或者他在 docs.rs 和 rustc 开发指南上的工作。

https://www.reddit.com/r/rust/comments/s0pcfa/lets_take_a_moment_to_thank_joshua_nelson_for_his/

Nicholas: 2022年如何加速 Rust 编译器

在 2016 年到 2020 年间,Nicholas 写了一系列名为“如何加速 Rust 编译器”的博文。 这些主要是关于其在 Rust 编译器上的工作,以及总体上关于 Rust 编译器速度进展的一些更新。现在他作为 Futurewei 的 Rust 团队一员,是时候重新开始这个博客系列了。

- https://nnethercote.github.io/2022/02/25/how-to-speed-up-the-rust-compiler-in-2022.html

- Compiler performance roadmap for 2022

IDE 和 proc 宏

这篇文章探讨了 rust-analyzer 如何计算 proc 宏,以及列出当前 ra 存在的问题(包括其他 IDE),并给出可行的解决方案:改进 proc 宏,让它对 IDE 更加友好。

https://veykril.github.io/posts/ide-proc-macros/

Rust 的Unsafe Pointer类型需要大修

来自 gankra 的博文。作者经常思考 Rust 中的Unsafe Pointer问题。

作者写了一本关于 unsafe Rust 的书(编按:也就是大家常说的 ”unsafe rust黑魔法”),还有关于 Rust 实现链表的书。同时,作者重新设计了 Rust 的指针 API,并为不安全的堆分配缓冲区设计了标准库的抽象,并维护替代的 Vec 布局。

作者经常思考 Rust 中Unsafe Pointer的问题,并表示讨厌它们。但不要误会作者的意思,他认为自己的所有工作都让它们变得更好,但它们仍然存在严重缺陷。事实上,他们已经变得更糟了。不是因为 API 发生了变化,而是因为我们处理这些东西时,我们对指针应该如何工作的理解太天真了。

他认为 Unsafe 指针类型中的三个大问题:

- 允许把整数声明为指针 (Integer-To-Pointer Casts Are The Devil)

- 引用的有效断言过于严格(References Make Really Strong Assertions)

- 偏移和位置很混乱(Offsets And Places Are A Mess)

并且在文中给出了一些解决方案。

https://gankra.github.io/blah/fix-rust-pointers

Rust 中#[doc]属性的改进

从 Rust1.54 开始,我们现在可以在属性中使用类似函数的宏。 #[doc] 属性有很多优点,让我们来看看其中的一些!

例如只需在lib.rs文件的顶部编写 README 即可:

#![allow(unused)] #![doc = include_str!("README.md")] fn main() { }

同时 README 文件现在将成为 crate 的文档,并且其中的代码示例也将被测试。

https://blog.guillaume-gomez.fr/articles/2021-08-03+Improvements+for+%23%5Bdoc%5D+attributes+in+Rust

let chains 有望在 1.62 到达稳定状态

如果下面的 pull 通过, let chains 的语法支持有望在 1.62 到到达稳定. 届时,下面的语法将会被支持.

很多小伙伴已经等了很久了.

fn main() { let outer_opt = Some(Some(1i32)); if let Some(inner_opt) = outer_opt && let Some(number) = inner_opt && number == 1 { println!("Peek a boo"); } }

https://github.com/rust-lang/rust/pull/94927

RFC 2789: Sparse Index

RFC 2789 不涉及具体的 Rust 语言特性,而是针对于 crates-io 索引的下载方式进行了变更,将原先使用的预先 Git Clone 模式改为了按需使用 HTTP 传输,相对优化了下载速度。

RFC 3151: Scoped Threads

标准库新增了带有命名域限制的线程,具体可见RFC 3151。举例如下:

#![allow(unused)] fn main() { let var = String::from("foo"); thread::scope(|s| { s.spawn(|_| println!("borrowed from thread #1: {}", var)); s.spawn(|_| println!("borrowed from thread #2: {}", var)); }); }

线程可以借用父线程的变量,且在命名域之外无效。也就是说,当命名域结束的时候,所有的线程会调用join()方法,等待线程结束。不过同时,如果任何线程在调用join()时panic,那么thread::scope()也会panic。不过,也可以手动调用join(),例如:

#![allow(unused)] fn main() { let greeting = String::from("Hello world!"); thread::scope(|s| { let handle1 = s.spawn(|_| { println!("thread #1 says: {}", greeting); }); let handle2 = s.spawn(|_| { println!("thread #2 says: {}", greeting); }); // 也可以不调,当 thread::scope 结束的时候,会自动调用 join // 等待未结束的线程结束 handle1.join().unwrap(); handle2.join().unwrap(); }); }

对于scope以内的变量,线程无法直接借用,需要通过参数的形式传递。例如:

#![allow(unused)] fn main() { thread::scope(|s| { s.spawn(|s| { s.spawn(|_| { println!("I belong to the same `thread::scope()` as my parent thread") }); }); }); }

社区热点

俄乌战争开启,Rust 官方博客向乌克兰报以人道主义关怀

Rust 官方在发布 1.59 稳定版的博客中,写道:

Today's release falls on the day in which the world's attention is captured by the sudden invasion of Ukraine by Putin's forces. Before going into the details of the new Rust release, we'd like to state that we stand in solidarity with the people of Ukraine and express our support for all people affected by this conflict.

中文翻译:

今天的发布正值普京的部队突然入侵乌克兰,吸引了全世界的注意力。在详细介绍新的Rust版本之前,我们要声明,我们声援乌克兰人民,并对所有受这场冲突影响的人表示支持。

因为国内外政治风向不同,这件事引起国内社区的热议,包括其他技术社区,尤其是前端社区,甚至还出现了去 react 官网留言辱骂的行为。

个人认为没有必要做出这么极端的行为。 Rust 官方在很早之前就说过,技术是离不开政治的。

那么,我们应该如何看待 Rust 官方这种行为呢?

- 从人道主义角度来说,支持乌克兰人民是必须的。但我们不仅仅支持乌克兰人民,我们也支持世界上任何一个受战争迫害国家的人民。

- Rust 官方有官方自己的立场,我们也无权干涉。

- 我们可以不在技术社区谈论政治,但作为世界公民有义务关注政治形势,因为我们每个人都不可能独善其身。

- 虽然技术离不开政治,但是在开源社区,至少还有开源行为规范,我们应该尽力遵守行为规范,共同维护和谐交流的社区。

- 无论是技术上还是政治觉悟上,要努力提升自己,不随大流,不被当枪使,不要人云亦云,有自己的独立思考。

https://blog.rust-lang.org/2022/02/24/Rust-1.59.0.html

AdaCore 和 Ferrous Systems 合作为 Rust 工具链 Ferrocene 认证各种安全标准

AdaCore 与 Rust 编程语言专家公司 Ferrous Systems 建立了战略合作伙伴关系,以进一步开发 Ferrous Systems 的 Ferrocene (二茂铁)Rust 工具链,以支持嵌入式任务和安全关键应用程序,并使其符合相关行业软件安全标准。

在工业应用中,人们对 Rust 的兴趣和使用越来越多,但对于汽车、航空航天和国防等安全关键市场,目前还没有经过安全认证的 Rust 工具链。Ferrocene 合作伙伴关系将支持希望将新兴的 Rust 语言技术集成到其安全关键应用程序中的客户的认证需求。

25 年来,AdaCore 通过投资新架构、语言和技术来支持安全和关键任务行业不断变化的需求。我们相信,在安全和安保关键领域都需要 Ada 和 Rust - AdaCore 产品管理和业务开发负责人 Quentin Ochem 如是说

对于 Ferrous Systems 而言,Ferrocene 是一个利用 Rust 的技术专长和与 Rust 社区的关系将 Rust 转变为任务和安全关键嵌入式软件开发的关键位置的机会。

对于 AdaCore 而言,通过与 Ferrocene 的开发合作,它补充了公司对 Ada 的长期承诺,并提供了将在安全认证的 Ada 工具链开发中获得的专业知识扩展到 Rust 社区的机会。

https://www.adacore.com/press/adacore-joins-forces-ferrous-systems-support-rust

出现首个用 Rust 编写的勒索软件即服务(RaaS)

2021 年 12 月,研究人员发现了一种名为ALPHV(又名“ BlackCat ”)的新型勒索软件即服务(RaaS, ransomware-as-a-service),它被认为是第一个创建和使用以Rust编程语言编写的勒索软件的专业网络犯罪组织。

以下是一些关键要点:

- 该组织正在积极招募前 REvil、BlackMatter 和 DarkSide 运营商

- 自 2021 年 11 月以来活动增加

- 丰厚的会员支出(高达 90%)

- 基于 Rust 的勒索软件可执行文件(快速、跨平台、针对每个受害者进行大量定制)

- 默认 AES 加密

- 内置权限提升(UAC 绕过、Masquerade_PEB、CVE-2016-0099)

- 可以通过 PsExec 传播到远程主机

- 使用 VSS Admin 删除卷影副本

- 停止 VMware ESXi 虚拟机并删除快照

与许多其他勒索软件威胁不同,ALPHV 是使用 Rust 开发的,Rust 是一种以其快速性能和跨平台功能而闻名的编程语言,导致在 2021 年 12 月和 2022 年 1 月期间观察到 Linux 和 Windows 变体。

尽管许多人认为 ALPHV 可能是第一个使用这种语言的“野外”勒索软件威胁,但Rust 勒索软件的概念验证已于 2020 年 6 月在 GitHub 上发布,尽管没有任何迹象表明这两者有任何关系有关的。

Catalin Cimpanu为The Record写道,更多恶意软件转向Rust的一个担忧是,与 C 和 C++ 相比,它被认为是一种更安全的编程语言。结果呢?安全防御者一直在寻找许多勒索软件中的编码弱点,如果更多人开始转向 Rust,那么找到这些弱点可能会变得更加困难。

最近观察到的 ALPHV 样本使用了 2021 年 11 月 4 日才发布的Zeroize版本 1.4.3,同时还使用了被 2021 年 11 月 16 日和 17 日发布的版本所取代的公钥加密版本。

虽然使用的许多 Rust crate 都有些明显,例如使用命令行界面和加密库,但使用 Zeroize(一个从内存中安全清除机密的库)似乎是故意尝试防止加密机密被泄露从受感染的主机中恢复。

https://krebsonsecurity.com/2022/01/who-wrote-the-alphv-blackcat-ransomware-strain/

AWS: Rust与可持续性

亚马逊官方博客上发表了“Sustainability with Rust”一文,通过研究和比较表明,Rust 在可持续性方面优于其他语言。该文章随后被ZDNet 报道。在 ZDNet 报道之后,Go 技术负责人 Russ Cox 发布了 14 条推文,称这篇文章严重误导了 Go 语言。

在亚马逊,Rust 已成为大规模构建基础设施的关键。2019 年,亚马逊成为 Rust 项目的赞助商。2020 年开始招募 Rust 维护者和贡献者,并与谷歌、华为、微软和 Mozilla 联手组建 Rust 基金会。

这篇文章引发的争议主要是以下几个方面:

- AWS引用的2017年前的研究存在偏见

2017 年的一项研究数据被用来证明 Rust 是一种节能编程语言。该研究侧重于测试 27 种编程语言的 10 个基准问题,并测量执行时间、能耗和内存使用峰值。这是引起争议的文章的第一部分。Russ Cox 认为其中使用 Go 1.6(2016 年 2 月)进行测试。“那已经是永远的过去式了。”最重要的是,这个“真正有趣的研究”假设计算机语言基准游戏是个可比较的程序来源,但了解这个网站的话就知道这完全不正确。

Cox 说 “几乎每个 C 程序都是有效的 C++ 程序,所以 C++ 不会输,尤其是没那么糟糕!” (此话存疑啊)

- 对比不公平

Cox 指出, Discord 的原帖中展示了一张 Go 服务器和等效 Rust 服务器的图表。Rust 具有更可预测的性能,并避免了像 Go 中的延迟峰值,但它们的性能大致相当。

在亚马逊的帖子里,在 Rust 和 Go 图表标出了“ms”与“µs”的时间刻度对比。但该对比的前提是,Rust 服务器进行了重大重写,并使用了新的数据结构和更多内存。

“这要么是完全没有理解 Discord 的帖子,要么就是公然说谎。”Cox 认为,这种对比方法在诚实、公平的情况下是很好的表达方式,“但 AWS 的帖子并非如此。”

不过,Cox 指出 Discord 的帖子是公平的。“它将 Go 服务器和 Rust 服务器进行了对比,并在文章后面单独绘制了 Rust 服务器在使用重写的数据结构和额外内存后的变化图,而 AWS 的帖子曲解了这一点。”

“在我看来,与其阅读那些将 Go 与 Rust 视为零和游戏的文章,我更愿意关注那些将 Go 和 Rust 视为相互补充、能很好协同工作的文章。”Cox 在最后说道。

编程语言之争从来没有停过,每种语言都有大批的拥护者,甚至存在“鄙视链”的说法,每年的编程语言榜单也是大家竞相关注的热点。但编程语言之间并非水火不容,开发者需要学会选择适合自己的语言。

- https://aws.amazon.com/blogs/opensource/sustainability-with-rust/

- https://www.infoq.cn/article/svgbvixxhcdf5mqvk3tv

gitoxide 可在一秒内检出(checkout)Linux 内核代码

gitoxide 是 Rust 实现的一个 Git 客户端。

测试结果是 v5.16 版在 ~874ms 内检出 Linux 内核,基于 Mac M1 pro (10 核) 测试。

https://github.com/Byron/gitoxide/discussions/349

Fermyon 推出WebAssembly 框架 spin

可以配合TO-D杂志第二季第一篇文章来看,能让人深刻理解这些开源项目背后的动机,这比单看他们的开源项目可有趣的多。话说回来,我觉得 Fermyon 的成立,应该是 deislabs 团队这这几年尝试的过程中看到了一些新的风口,他们的项目应该多多关注。

《TO-D 杂志》第二季第一篇文章正式发布,这篇文章是关于微软 DeisLabs 的故事,欢迎大家阅读转发 https://2d2d.io/s2/deislabs/ ,Deis Labs 开发了不少非常前沿的 WebAssembly 和 Rust 项目,现在他们团队中九人出来创业,成立新公司 Fermyon。

关于 Fermyon 名称由来的猜想:这个单词比较贴近费米子(fermion)。所以查了下相关概念,得出一些推论。费米子和玻色子都是宇宙基本粒子,都有自旋属性。但是费米子喜欢独来独往(泡利不相容原理,只适合费米子。 在任何量子系统中,两个费米子无法占据同一个量子态),而玻色子喜欢共享。用费米子来对应wasm的沙盒隔离性。而他们的主打项目名叫 spin 。他们这么费劲起这个名字,我想到一个原因就是避免别人抢注商标。因为之前发生过 Wasmer 抢注商标的事(Wasmer 抢注了WasmEdge的商标,甚至还把 WebAssembly 抢注为自己公司的商标)。这也算是一种商标保护。

漏洞赏金平台 Hackerone 接受 Rust 的漏洞报告

Rust 官方博客之前报告的 std::fs::remove_dir_all 函数漏洞,价值 4000 刀。

https://hackerone.com/reports/1520931

AUTOSAR 宣布成立新的汽车软件Rust编程语言工作组

在 Rust 社区中广为人知的 Christof Petig 已同意接任(Rust工作组)发言人的角色。他拥有 25 年的C++经验,在此期间已成为 Rust 爱好者。Christof 在最初的讨论中总结道,"用 Rust 编写的代码经过检查,以确保内存安全且不受数据抢占的影响。同时,由于所有可能的检查都是在编译时检查的,因此运行时开销可以忽略不计。这意味着 Rust 的性能可与C++相媲美。”由于汽车领域的其他标准化机构(如Khronos或SAE)符合此类评估,因此嵌入式软件的重点是共同努力实现有效的标准化。

所有这些对于 AUTOSAR开发合作伙伴关系及其社区来说并不陌生。AUTOSAR在C++14编码指南方面经验丰富,希望保持其创新传统,并成为以功能安全和汽车网络安全为重点的标准化机构。也因此最终决定,在功能安全工作组(WG-SAF)内成立一个小组并调查如何在AUTOSAR自适应平台中将Rust运用起来。该小组将于2022年4月正式启动,并计划制作两份文件。其中一份文件将提供有关如何在 AUTOSAR Adaptive Platform 项目环境中使用 Rust 的指导。另一个文档将提出 Rust 上的编码指南。

这篇消息目前被官方网站删除,但是在 GitHub 相关issues中,Christof Petig 透露会在之后修改文章以后重新放出来。工作组的事情正在继续中。

关于如何看待 Autosar 成立 Rust 工作组这件事,可以看知乎用户 @萧猛 的一个答案:https://www.zhihu.com/question/522187444/answer/2393987811

Areweyet 列表更新

有关 Rust 目前在各个领域的状态的汇总。

https://wiki.mozilla.org/Areweyet

《Rust 编码规范》更新到 V0.3 版本

《Rust 编码规范》更新到 V0.3 , 欢迎大家持续评审、补充和参考

https://rust-coding-guidelines.github.io/rust-coding-guidelines-zh/

Alacritty六周年生日快乐!

<video src="https://assets.repography.com/file/repography-assets/blog/happy-birthday-alacritty/alacritty-structure.mp4" controls="controls" width="500" height="300"></video>

六年前的2月21号(2016年2月21号),Joe Wilm提交了第一个commit到Alacritty的Git仓库:

commit 621776cd94890936b24f3abb8b7ec1f36dad9150

Author: Joe Wilm <joe@jwilm.com>

Date: Sun Feb 21 08:15:41 2016 -0800

Initialize new cargo binary project

今天是Alacritty的6周岁生日,这篇文章使用Repography 分析和回顾了Alacritty的repo历史

https://repography.com/blog/happy-birthday-alacritty

Google对25名Rust开源贡献者做出奖励

Rust 是系统级编程语言,重点关注内存安全。Google 在一些项目中使用了 Rust:包括 Android、Fuchsia 和 ICU4X;并一直参与在 Linux 内核中评估 Rust 的工作。Google 也是 Rust 基金会的创始成员。

利用 gitoxide 可以在一秒内检出 Linux 内核

gitoxide 是用纯 Rust 实现的一个精简、快速和安全的 Git 实现。此外,它还以各种小 crates 的形式提供了一套易于使用的API,方便我们轻松实现自己的工具。

“checkout” 代表检出文件。如果没有索引,git 将从源码树中创建一个索引,并使用内存中的索引来检出文件。

gix 是由 gitoxide 驱动的二进制程序,它比 git 的多线程 checkout 速度快 1.8 倍。这意味着在一台 10 核 MacBook + tmpfs 的组合上,可以在 ~874ms 内检出 Linux 内核 v5.16 。

学习资源

这里刊登了最近三个月值得学习的开源项目和博客文章等资源。

开源项目

值得学习的开源项目

type-exercise-in-rust: 数据库表达式执行的黑魔法:用 Rust 做类型体操

该项目通过在数据库系统中实现表达式框架来学习 Rust 黑魔法,围绕 Rust 程序员如何使用 Rust 编程语言构建数据库系统展开:利用 Rust 类型系统来最小化运行时成本,并使用安全的 Nightly Rust 使开发过程更容易。

https://github.com/skyzh/type-exercise-in-rust

jotsy: 一个自托管、免费和开源的笔记应用程序

后台基于 Rust / Skytable / Tokio / Axum / Askama 实现。前端就是纯 HTML、CSS 和 JavaScript 构建。

功能非常简单,可以基于该项目去扩展功能,也可以学习 Rust 使用。

bevy 实现的扫雷游戏

git-smart-checkout: Rust实现的智能 git checkout 命令行应用

这是作者写的第一个 Rust 项目,然后reddit 网友给他的代码留了一些 review 建议:

- https://github.com/craciuncezar/git-smart-checkout/blob/main/src/git_client.rs#L7 这些都可以只是函数。Rust不是OOP,所以如果你不需要状态,不需要用结构把所有这些东西绑定在一起也是可以的。

- 对于GitBranch,你可以只需要

#derive(Clone)而不是自己实现它。https://github.com/craciuncezar/git-smart-checkout/blob/main/src/git_client/git_branch.rs#L4 参考文献:https://doc.rust-lang.org/rust-by-example/trait/derive.html。 - 在Rust中,如果你能在可能的情况下将

clone给调用者负责,而不是自己去做,那是最好的,在 https://github.com/craciuncezar/git-smart-checkout/blob/main/src/git_client/utils.rs#L3 ,我认为to_vec在底层做了一个clone。我的意思是,如果你需要某个东西的明确拷贝,就用所有权而不是引用,但让调用者决定他是想给你所有权还是克隆这个值给你。 - 在这个只在一个地方使用的

fn的具体案例中,我认为你一般不需要它,但如果你要在多个地方使用它,你可以把Vec传成可变的,并立即排序,不需要clone。你也可以将Vec<GitBranch>包装成一个新的类型,并为其实现fnhttps://rust-unofficial.github.io/patterns/patterns/behavioural/newtype.html。 - 你的模块和类型的另一种构造可以是

git、git::client、git::client::switch_to_branch、git::Branch。 - 当把一个

Vec引用传递给一个函数时,通常作为切片接收:branches: &[GitBranch]更方便。调用代码保持不变,但现在可以传递数组以及Vec去调用该函数。通常情况下,String和&str也是如此。 - 建议是试一下

anyhow。你会发现错误处理会变的容易。

【系列】 数据库表达式执行的黑魔法

type-exercise-in-rust (GitHub) 中已经包含了一整套数据库执行器的类型设计,本系列将详细介绍整个设计过程中的思考过程和解决方案。

mwbot-rs:快速构建WikiBot

用 Rust 构建快速的 Wikipedia 机器人。

- https://blog.legoktm.com/2022/01/21/building-fast-wikipedia-bots-in-rust.html

- https://gitlab.com/mwbot-rs

flux: 用 Rust 和 wasm 重新创建 macOS的 Drift 屏幕保护程序

作者一直迷恋 Drift 屏幕保护程序,自从它出现在macOS Catalina。作者使用 Rust 和 wasm 重新在浏览器中创建了该效果.

https://github.com/sandydoo/flux

Jotsy:一个由Skytable、Axum和Tokio支持的自托管笔记应用程序

我很高兴宣布jotsy - 一个自托管,免费和开源(Apache-2.0)的笔记程序,使用Skytable,Axum和Tokio构建。jotsy最重要的目标是简单,专注于最重要的事情,记笔记。

- https://www.reddit.com/r/rust/comments/skizcp/jotsy_a_selfhosted_notes_app_powered_by_skytable/

- https://github.com/ohsayan/jotsy

让我们用 Rust 和 Yew 0.19 构建一个 WebSockets 项目

作者介绍如何使用 Yew、yew-router、yew-agent 和其他几个项目构建一个聊天应用程序

https://blog.devgenius.io/lets-build-a-websockets-project-with-rust-and-yew-0-19-60720367399f

用 Rust 实现 NTFS 文件系统

是时候用 Rust 重写我们的系统软件并摆脱 C 的陷阱了。这个过程中还包括文件系统支持等基础知识。作者接受了在 Rust crate 中实现 NTFS(Windows 使用的主要文件系统)的挑战,并且从固件级别到用户模式都同样可用。

https://fosdem.org/2022/schedule/event/misc_ntfs_rust/

Rust 实现 flappybird 游戏

https://github.com/JerzySpendel/flappybird

toipe: 终端打字测试应用

https://github.com/ChaosStudyGroup/toipe

neural-network-from-scratch 项目是一个用 Rust 从头开始编写的神经网络库

以及一个用于构建 + 训练神经网络 + 可视化其输出的基于 Web 的应用程序

https://github.com/Ameobea/neural-network-from-scratch

博文教程

一本开源的线上 Rust 新书 《High Assurance Rust: Developing Secure and Robust Software》

看上去作者像是安全从业背景。不过目前内容还未写完,看内容组织结构比较适合进阶。

Rust 借用检查规则注定被“打破”

这篇文章想表达的内容并不是真的要“打破”借用检查,它是提供了一个视角来介绍 Rc/Arc/Cell/RefCell/Mutex/Atomics等。

Shaking off the Rust : 系列 Rust 学习博客

通过实际构建东西,将在此过程中了解一系列技术概念,并提高 Rust 的能力。

nom 解析比特流

该文章介绍了如何使用 Nom v7 来解析二进制数据,比如 DNS 协议头。

在该文章相关的 Reddit 讨论中,有网友提出解析 DNS 协议头并不需要使用 nom,而利用位运算来提取相关部分是常规操作。并提供了一个库 bitstream-io,提供了方便的接口来处理媒体编解码时候可能出现的一些位偏移问题。但作者使用nom是为了玩 https://adventofcode.com/,学习目的。

其他网页也给出了一些看法和库,了解细节可以看看 reddit 讨论。

当然,Rust 生态也有生产级的 DNS 解析库 : trust-dns 。

- https://blog.adamchalmers.com/nom-bits/

- https://www.reddit.com/r/rust/comments/t52iuz/parsing_bitstreams_with_nom/

Bevy 游戏开发者指南(非官方)

Rust写Python扩展的9个原则

- 创建一个同时包含 Rust 和 Python 项目的仓库。

- 使用

maturin&PyO3在 Rust 中创建 Python 可调用的翻译器函数。 - 让 Rust 翻译器函数调用 “好的” Rust 函数。

- 在 Python 中预分配内存。

- 将好的 Rust 错误处理转换为好的 Python 错误处理。

- 使用

Rayon和ndarray::parallel的多线程,返回任何错误。 - 允许用户控制并行线程数。

- 将好的动态类型 Python 函数转换为好的 Rust 通用函数。

- 同时创建 Rust 和 Python 的测试。

https://towardsdatascience.com/nine-rules-for-writing-python-extensions-in-rust-d35ea3a4ec29

了解原子和内存排序的工作原理

作者使用一个带有简单单元测试的 repo 增强对这个主题的理解。其中,包含了一个简单例子和一个复杂例子。

https://github.com/blasrodri/atomic-story

Rust 和 Valgrind 配合使用

这篇文章讲了为什么 Valgrind 对 Rust 是有用的。Valgrind 不止是内存错误探测工具。

https://nnethercote.github.io/2022/01/05/rust-and-valgrind.html

让 include_dir 更加现代化

include_dir 这个crate提供了一个include_dir!宏,用于在编译时将整个目录树嵌入你的二进制文件中。这就像include_str!,但针对整个目录。

作者最近做了大量的工作来改善这个crate,增加了想要的功能,改善了编译时间,并巩固了它的核心目标。

你可以查看入门指南以了解更多。

https://adventures.michaelfbryan.com/posts/bringing-include_dir-into-the-modern-era/

使用 Rust 为 RISC-V OS 实现自旋锁

自旋锁是最基本的同步实现之一,也是实现操作系统时首先要考虑的组件之一。

本文将简要回顾自旋锁的基础知识,如何在 Rust 中为自制操作系统实现它,以及它相对于 C 语言的优势。

本文针对 RISC-V 架构平台。

CPU 支持原子操作指令,这些指令也用于实现自旋锁。在 RISC-V 的情况下,有 AMO(原子内存操作)和 Load-Link/Store-Conditional 指令,它们都可以执行或实现以下操作。

https://vmm.dev/en/rust/spinlock.md

使用 Nom 解析文本

本教程使用Nom解析输入文件到一个Advent of Code的谜题。

https://blog.adamchalmers.com/nom-chars/

Bevy是如何使用 Rust traits 来添加标签的

出于好奇,作者最近开始关注Bevy的开发,Bevy是一个用Rust编写的游戏引擎。今天作者想谈谈Bevy如何使用Rust特性让用户非常方便地为元素添加标签。

注意: 这里的实现实际上是非常通用的, 您可以很容易地将其应用到任何其他Rust项目

https://deterministic.space/bevy-labels.html

(基础)精美图表详解线段树!

给定一个长度为N的数组arr,如果有以下操作:

查询区间[l,r]之间的最大值/最小值;

- 更新给定下标i的对应的值arr[i];

- 则可以使用线段树来高效解决上述场景的查询和更新需求;

线段树的时空复杂度:

- 时间复杂度:O(logN)

- 空间复杂度:O(N)

(Basic) Segment Trees with beautiful diagrams!

为什么静态语言会受到复杂性的影响

编程语言设计社区的人们努力使他们的语言更具表现力,具有强大的类型系统,主要是通过避免最终软件中的代码重复来增加人体工程学;然而,他们的语言越有表现力,重复就越突然地渗透到语言本身。

这篇文章与语言无关,对编程语言理论感兴趣的朋友可以一读。

https://hirrolot.github.io/posts/why-static-languages-suffer-from-complexity

quickref.me Rust

QuickRef.ME 是一个汇聚了大部分语言的语法索引页, 其中也包含了 Rust, 可以帮助大家快速找到想用的语法.

博文:深入探讨Rust中的内存分配

https://ysantos.com/blog/malloc-in-rust

使用 Rust 将你的步行数据可视化到地图上

结合 Rust,OSRM, OpenStreetMap 的一次尝试。

https://blog.dend.ro/mapping-my-walks-osrm-rust/

一次 Rust 硬件开发的尝试

作者开发了一个 USB 硬件密码存储器。

https://github.com/sjm42/blackpill-usb-pwdstore

async-await:协作式调度 vs 抢占式调度

抢占式调度

抢占式调度是指任务的调度不受开发人员控制,完全由运行时管理。无论程序员是启动同步任务还是异步任务,代码都没有区别。例如,Go编程依赖于抢占式调度。它的优点是更容易学习:对于开发人员来说,同步代码和异步代码之间没有区别。此外,几乎不可能误用:运行时会处理所有事情。

协作式调度

通过协作调度开发人员负责告诉运行时一个任务何时需要花费一些时间等待 I/O。await 这是关键字的确切用途。这是运行时(和编译器)的指示,该任务将花费一些时间等待操作完成,因此计算资源可以同时用于另一个任务。它的优点是速度极快。基本上开发人员和运行时正在协同工作,以充分利用可支配的计算能力。协作调度的主要缺点是它更容易被误用:如果 aawait 被遗忘(幸运的是,Rust 编译器会发出警告),或者如果事件循环被阻塞超过几微秒,它会对系统的性能产生灾难性的影响。 文章对两种调度进行了更细致的介绍:

https://kerkour.com/cooperative-vs-preemptive-scheduling/

为什么 Rust 标准库要保持足够小?

通常,刚接触 Rust 编程语言的人会问“为什么标准库中没有随机数生成/正则表达式/日期时间/序列化等基本功能?为什么我需要为这些功能导入质量未知的第三方库?

这篇文章给你解释。

https://blog.nindalf.com/posts/rust-stdlib/

Panic 与 异步取消 Part 1

Rust 语言团队 leader Niko的这篇文章的重点是解释 Rust 的恐慌(Panic)哲学,并解释为什么niko认为恐慌和取消非常相似。

https://smallcultfollowing.com/babysteps//blog/2022/01/27/panics-vs-cancellation-part-1/

Rust 的热加载

本文探讨了 Rust 中的热加载在 windows 和 Linux 上的不同差异.

https://johnaustin.io/articles/2022/hot-reloading-rust

Rust中的内存映射文件

作为一名Rust新手,作者想在自己的第一个项目中处理一些非常大的二进制文件,读取它们,遍历它们,等等。 但是作者在搜索支持内存映射文件的Rust库时发现,memmap有超过700万次下载,但是它已经超过3年没有更新。 以下是作者的一些顾虑:

- 可以想象在过去的三年里,很多事情都发生了变化。但是这个库三年没有更新了,这个库还有用吗?

- 有没有更好的(非废弃的)替代库?

- 如果我用这个库作为依赖项启动一个大型项目,我将来会遇到什么问题?

其实针对这个问题,RUSTSEC上已经有条目(RUSTSEC-2020-0077)针对这个风险作出了提示,并给出了两个可选的替代开源库:

数据结构和算法(Rust)

内容非常丰富的一本开源 Rust 算法和数据结构的书。

https://github.com/QMHTMY/RustBook

cargo 和 pip 是不同的

文章作者总结了11条,这两个包管理器的不同之处,其实这些不同也牵涉到语言级的原因。

https://blog.williammanley.net/2022/02/23/pip-and-cargo-are-not-the-same.html

好文:对Rust中unsized变量的分析

在Rust语言中,unsized变量一直都没有人去认真做过这方面的分析工作,编译器一直也没有对这块做太多的功能支持。作者在这个主题上从历史开始做了深入的详尽的分析。值得学习。

https://poignardazur.github.io/2022/02/23/rust-unsized-vars-analysis/

Rust 和 OpenCV

这是一篇 OpenCV 在 Rust 中的使用指导, 非常的详尽.

https://blog.devgenius.io/rust-and-opencv-bb0467bf35ff

我的第一个 Clippy Lint

作者自己动手写了一个clippy的 lint,其过程比他想象中的要简单和容易测试的多. Clippy团队在提供示例、快速代码审查和大量易于使用的共享utils代码方面做了大量工作。

https://jamesmcm.github.io/blog/2022/03/26/my-first-clippy-lint/#en

Rust wgpu 图形编程系列教程

Rust 使用 I2C 的方式读取传感器数据

本文讲述了如何使 Embedded Rust 提供的驱动, 通过 I2C 的方式来读取和修改传感器的数据.

https://lupyuen.github.io/articles/rusti2c

过程宏内幕详解:Part 1

你有没有想过Rust的过程宏如何工作?在这个博客文章中,我们将进入细节!我们团队的成员Vladislav Beskrovny,最近谈到了RustCon的主题。该系列基于这个主题,有一些略微的修改和添加。

在这篇文章中,我们将查看Rust宏的基础知识并进入过程宏细节,密切关注他们的API。

https://blog.jetbrains.com/rust/2022/03/18/procedural-macros-under-the-hood-part-i/

开源书籍《Effective Rust》

模仿 《Effective C++》 内容风格而编写的一本 Rust 新的开源书。

构成本书的项目分为六个部分:

- Types:围绕 Rust 的核心类型系统提出的建议。

- 概念:构成 Rust 设计的核心思想。

- Dependencies:关于使用 Rust 包生态系统的建议。

- 工具:关于如何通过超越 Rust 编译器来改进代码库的建议。

- 异步 Rust:使用 Rustasync机制的建议。

- Beyond Standard Rust:当你必须在 Rust 的标准、安全环境之外工作时的建议。

https://www.lurklurk.org/effective-rust/intro.html

使用Rust实现一个有大小限制可过期的LRU缓存

跟着作者一起学习,如何使用Rust编程语言为DNS服务器实现一个有大小限制的LRU缓存,并有过期的条目。

https://memo.barrucadu.co.uk/dns-cache.html

Rust 交叉编译

https://kerkour.com/rust-cross-compilation

高校公开课

斯坦福大学 CS110L

斯坦福大学CS110L,于2020年开设,b站有录播视频 : https://www.bilibili.com/video/BV1Ra411A7kN

该课程持续开设,2020 和 2021 的课件是不一样的,2021 加了一节关于程序静态分析和动态分析的内容,2022年也继续。

KAIST CS431: Concurrent Programming

Rust101: 与伦敦帝国理工学院计算社会系合作的Rust系列讲座

youtube地址:Rust 101 Lecture Series

线上视频

教程推荐: Rust嵌入式开发入门视频教程系列

由 Rust 中文社区 myrfy 来制作,其中也包含了一些非嵌入式领域需要懂的基础知识,比如链接脚本工作机制:

视频合集地址:https://space.bilibili.com/500416539/channel/collectiondetail?sid=177577

使用 Opencv 和 Rust 进行面部和眼部识别

这是一个教学视频, 使用 Opencv 和 Rust 进行面部和眼部识别.

需要自己科学上网, 关注相关方面的小伙伴可以看看.

学术动态

学术动态 | Rust

来自于 MIT-PDOS 的研究型项目: terra

一个用 Rust 编写的大型地形渲染库,基于 wgpu。

https://github.com/fintelia/terra

清华大学: 2022 全国大学生操作系统比赛

论文 | 删除(Yanked) Rust crate 注册仓库中已发布包的实证研究

Rust 的软件包管理器 Cargo 提供了一个 yank 机制来支持发布级别的弃用,这可以防止包依赖于 yanked 的版本。大多数先前的研究都集中在代码级(即弃用的 API)和包级弃用(即弃用的包)上。然而,很少有研究关注发布级别的弃用。在这项研究中,调查了 yank 机制的使用频率和方式、其使用背后的基本原理以及在 Cargo 生态系统中采用 yank 发布。我们的研究表明,Cargo 中 9.6% 的包裹至少有一个 yanked release,并且 yanked release 的比例从 2014 年到 2020 年不断增加。包所有者出于其他原因而不是撤回有缺陷的 release,例如修复不遵循语义版本控制的版本或指示已删除或替换包的版本。此外,我们发现 46% 的包直接采用了至少一个 yanked 版本,并且 yanked 版本通过依赖网络传播,这导致生态系统中 1.4% 的版本具有未解决的依赖关系。

https://arxiv.org/abs/2201.11821

论文 | DuVisor:通过委托虚拟化的用户级管理程序

当今的主流虚拟化系统由两个协作组件组成:访问虚拟化硬件的内核驻留驱动程序和提供 VM 管理和 I/O 虚拟化的用户级帮助进程。然而,这种虚拟化架构在安全性(大的攻击面)和性能方面都存在内在问题。虽然通过将函数卸载到用户模式来尝试最小化内核驻留驱动程序的工作很长,但他们面临着安全性和性能之间的基本权衡:更多的卸载可能会减少内核攻击面,但会增加运行时环之间的交叉辅助进程和驱动程序,因此性能成本更高。

本文探索了一种称为委托虚拟化的新设计,它将控制平面(内核驱动程序)与数据平面(辅助进程)完全分离,从而消除了内核驱动程序的运行时干预。一旦内核驱动程序完成初始化,由此产生的用户级管理程序,称为 DuVisor,可以处理所有 VM 操作,而不会陷入内核。DuVisor 使用新的委托虚拟化扩展来改进现有的硬件虚拟化支持,以直接处理 VM 退出、配置虚拟化寄存器、管理第 2 阶段页表和用户模式下的虚拟设备。目前已经在开源 RISC-V CPU 上实现了硬件扩展,并在硬件之上构建了一个基于 Rust 的管理程序。对 FireSim 的评估表明,DuVisor 的性能比 KVM 高 47 倍。

https://arxiv.org/pdf/2201.09652.pdf

论文 | Minotaur:多资源区块链共识

基于资源的共识是无需许可的分布式账本系统的支柱。此类协议的安全性从根本上依赖于系统中积极参与的资源水平。各种不同的资源(以及相关的证明协议,在文献中有时称为 PoX)提出了一个基本问题,即是否可以串联利用其中的许多资源并构建多资源共识协议。组合不同资源的挑战在于实现它们之间的可替代性,从某种意义上说,只要所有资源的累积对抗性力量有限,安全性就会保持不变。

在这项工作中,论文提出了Minotaur,这是一种多资源区块链共识协议,它结合了工作量证明 (PoW) 和权益证明 (PoS),并证明了它的最佳可替代性。他们用 Rust 实现了客户端。

论文 | 使用多方会话类型(Multiparty Session Types)的 Rust 中的无死锁异步消息重新排序

Rumpsteak 是一个 Rust 框架,用于安全有效地实现 消息传递 异步程序。它使用多方会话类型来静态保证不存在通信错误,例如死锁和异步子类型化,以优化通信。

论文 | Zef:低延迟、可扩展、私人支付

这是第一个支持任意规模匿名数字硬币支付的拜占庭容错 (BFT) 协议。Zef 遵循 FastPay 的通信和安全模型。

https://arxiv.org/pdf/2201.05671.pdf

学术动态 | WebAssembly

卡内基梅隆大学论文:使用 WebAssembly 的可证明安全的多语言沙箱

该论文探索了两种生成可证明wasm代码的方法:

- 传统形式化方法生成数学的、经过机器检查的安全性证明。对应实现为 vWasm 编译器。

- 将 wasm 语义小心地嵌入到安全的 Rust 代码中,以便 Rust 编译器能够以良好的性能emit安全的可执行代码。对应实现为 rWasm 编译器。

本文贡献:

- vWasm 是第一个经过验证的沙盒编译器,通过传统的机器检查证明实现。

- rWasm 是第一个可证明安全的沙箱编译器,具有极具竞争力的运行时性能。通过利用 Rust 的安全保证,rWasm 实现了第一个多语言多平台的沙箱编译器。它是提供了可证明的保证,而无需编写正式的证明。

rWasm 机制:

- 编译策略:

- 通过一个编译前端将wasm编译为 IR

- 包括一个栈和死代码分析器

- 通过一个后端将 IR 打印为 Rust 代码

- 通过 rustc 编译器生成机器代码

- rWasm是通过 Safe Rust 实现的

- rWasm的关键是: 通过将低级代码(Wasm)提升为高级代码(Rust)来完成对低级代码的仿真,从而得到高级语言的保证。因为想要证明的安全沙盒的高级属性本质就是内存安全。

https://www.jaybosamiya.com/publications/2022/usenix/provably-safe-sandboxing-wasm.pdf

论文 | 将 C 程序移植到 WebAssembly 的安全风险

WebAssembly 是越来越多地使用的跨平台应用程序的编译目标。在本文中,我们调查是否可以透明地将 C 程序交叉编译到 WebAssembly,如果不能,移植会对它们的安全性产生什么影响。我们编译了 17,802 个程序,这些程序对 64 位 x86 和 WebAssembly 二进制文件存在常见漏洞,我们观察到执行 4,911 个二进制文件会在这些平台上产生不同的结果。通过人工检查,我们确定了造成这种差异的三类根本原因:使用不同的标准库实现、WebAssembly 中缺乏安全措施以及执行环境的不同语义。我们描述了我们的观察结果,并讨论了从安全角度来看至关重要且最需要开发人员关注的观察结果。我们得出结论,将现有的 C 程序编译为 WebAssembly 以进行跨平台分发可能需要修改源代码;否则,WebAssembly 应用程序的安全性可能会受到威胁。

https://arxiv.org/pdf/2112.11745

开源动态

按领域记录 Rust 开源生态。

开源观察 | 数据处理

Skytable: 高性能、安全可靠的实时 NoSQL 数据库

Skytable 致力于提供最好的 键值对(key/value) 存储、文档(document)存储和列式(columnar)数据库。Skytable 以前称为 TerrabaseDB(然后是 Skybase),也被社区昵称为“STable”、“Sky”和“SDB”。

Skytable 目前正在开发中,但可以用作高性能、安全和持久的键值存储。

roaring-rs: 更好的压缩位集(bitset)

相关论文: 使用 Roaring bitmap 获得更好的位图性能 中描述到:

位图索引常用于数据库和搜索引擎。通过利用位级并行性,它们可以显着加速查询。但是,它们可以使用大量内存。因此我们可能更喜欢压缩位图索引。在 Oracle 的引领下,位图通常使用运行长度编码 (RLE) 进行压缩。在这项工作中,我们引入了一种新形式的压缩位图,称为 Roaring,它使用打包数组而不是 RLE 进行压缩。我们将其与两种基于 RLE 的高性能位图编码技术进行比较:WAH(字对齐混合压缩方案)和 Concise(压缩“n”可组合整数集)。在合成数据和真实数据上,我们发现 Roaring 位图通常压缩得更好。

Roaring 位图数据结构的 Rust 移植版本。位图(或位集)是一个二进制数组,我们可以将其视为整数集的有效且紧凑的表示。例如,集合和可能以二进制形式存储为

10011000和10110000。我们可以使用位图(例如,在我们的例子中为10111000和10010000)上的按位运算(OR、AND)来计算两个这样的对应列表之间的并集或交集。Roaring 将位图集条目作为

32位整数存储在简洁的两级索引中。与两种有竞争力的位图压缩方案 WAH 和 Concise 相比,Roaring 使用的内存更少,速度更快。

Roaring BitMap 简称为RBM,其实现思路:

将32位无符号整数按照高16位分桶,即最多可能有2^16=65536个桶,论文内称为container。存储数据时,按照数据的高16位找到container(找不到就会新建一个),再将低16位放入container中。也就是说,一个RBM就是很多container的集合。

更多内容参考: https://www.jianshu.com/p/818ac4e90daf

Quickwit 0.2 为 ClickHouse 和 Kafka 带来全文搜索

Quickwit 号称用于日志管理的云原生和高性价比搜索引擎。Quickwit 是为日志构建的下一代搜索和分析引擎。它是 Elasticsearch 的一种高度可靠且具有成本效益的替代方案。

当前 0.2 版本发布,将支持 ClickHouse 和 Kafka 的全文搜索,同时新版本主要介绍以下功能:

-

准确一次性提取 Kafka 原生数据

-

搜索流 API

-

PostgreSQL 元存储

-

标签修剪

-

适当的索引管道

Mako: 机器学习的数据处理库

Mako是一个数据处理库,主要用于机器学习。它提供了高效的 pipe 来构建有向非循环数据流图,并提供了一个 DataLoader 来在单独的线程中运行该图。它还提供了通用的标记器和批处理工具来处理文本数据。

https://github.com/Sidekick-AI/mako

Arrow2 发布 v0.9

Arrow2 是 Apache Arrow 的 Rust 实现,是继 C++ 实现之后,Arrow 功能最完整的实现。v0.9 的主要更新:

由 std Vec 支持,从而使其成为:

- 与 Rust 生态的其它的零拷贝

- 更少的 unsafe

- 更符合人体工程学

- 编译速度更快

- 相同的性能

- 支持同步和异步读取和写入 Apache Avro

flatbuffers 依赖被 planus 取代,这是 Rust 中 flatbuffers 规范的重新实现

安全性改进和常规维护

完整的更改列表:https://github.com/jorgecarleitao/arrow2/releases/tag/v0.9.0

Apache Datafusion 正在考虑采用它作为其后端,请参阅 https://github.com/apache/arrow-datafusion/issues/1532

Databend 发布0.7版本,部署更容易,查询更迅速

- 共享存储(弹性)

- 存储计算分离(弹性):存算分离后,增加计算节点时不需要做数据迁移,可以达到秒级增加计算资源的效果。算力的扩张很快。

- 计算资源可以根据不同的业务做划分(弹性):例如下图中的node4可以作为数据导入专用节点,node3作为BI计算专用节点。

- 资源扩张秒级弹性(弹性):这样的架构计算节点异构化,资源分配粒度更细,资源控制更加灵活。

Blog: https://databend.rs/blog/databend-0-7-0-release

PancakeDB 的分享

- https://rustacean-station.org/episode/059-martin-loncaric/

- https://pancakedb.com/

- https://github.com/pancake-db/pancake-db

开源观察 | 云原生

Fermyon 推出WebAssembly 框架 spin

可以配合TO-D杂志第二季第一篇文章来看,能让人深刻理解这些开源项目背后的动机,这比单看他们的开源项目可有趣的多。话说回来,我觉得 Fermyon 的成立,应该是 deislabs 团队这这几年尝试的过程中看到了一些新的风口,他们的项目应该多多关注。

《TO-D 杂志》第二季第一篇文章正式发布,这篇文章是关于微软 DeisLabs 的故事,欢迎大家阅读转发 https://2d2d.io/s2/deislabs/ ,Deis Labs 开发了不少非常前沿的 WebAssembly 和 Rust 项目,现在他们团队中九人出来创业,成立新公司 Fermyon。

关于 Fermyon 名称由来的猜想:这个单词比较贴近费米子(fermion)。所以查了下相关概念,得出一些推论。费米子和玻色子都是宇宙基本粒子,都有自旋属性。但是费米子喜欢独来独往(泡利不相容原理,只适合费米子。 在任何量子系统中,两个费米子无法占据同一个量子态),而玻色子喜欢共享。用费米子来对应wasm的沙盒隔离性。而他们的主打项目名叫 spin 。他们这么费劲起这个名字,我想到一个原因就是避免别人抢注商标。因为之前发生过 Wasmer 抢注商标的事(Wasmer 抢注了WasmEdge的商标,甚至还把 WebAssembly 抢注为自己公司的商标)。这也算是一种商标保护。

为什么是 Spin ?

Fermyon 对在 WebAssembly 中编写微服务和服务器端 Web 应用程序的前景感到极度兴奋。他们在构建 Wagi 时对此进行了预览。但有了 Spin,我们将事情提升到了一个新的水平。更具体地说,Spin 提供了一个构建应用程序的框架。

Spin 是一个用于 Web 应用程序、微服务和其他类似服务器的应用程序的框架。它提供了用于编写 WebAssembly 模块的接口,这些模块可以执行诸如响应 HTTP 请求之类的操作。Spin 的一个独特之处在于它是一个多语言框架。Rust 和 Go 在 Spin 中都有强大的支持,但您也可以编写 Python、Ruby、AssemblyScript、Grain、C/C++ 和其他语言。

Spin 是一项基础性的新技术,它为 Fermyon 正在构建的东西设定了步伐。Fermyon 的目标是为下一代微服务和 Web 应用程序构建一个优秀的开发平台,实现无服务器计算长期以来追求的许多目标。

Fermyon WebAssembly Language Guide

本指南跟踪对将语言编译为 WebAssembly 的支持。它分为三个部分:支持前 20 种语言、WebAssembly 特定语言和其他著名语言。我们跟踪该语言是否可以编译为在浏览器、其他非浏览器环境和WASI环境中运行。在每种语言的详细信息页面中,我们尽最大努力不仅说明当前的支持级别,还指出一系列有用的资源。

- https://github.com/fermyon/wasm-languages

- https://www.fermyon.com/wasm-languages/webassembly-language-support

Blueboat 是 Cloudflare Workers 的开源替代品。

Blueboat 旨在成为面向无服务器 Web 应用程序的开发人员友好型多租户平台。遵循整体方法:我们尝试在 Rust 中本地实现常用库(在 Web 应用程序上下文中)的特性,以替换原生 Node 插件,提高性能并减少重复代码。Blueboat 的架构可确保平台的安全性,防止代码重复并保持低开销。

https://github.com/losfair/blueboat

Starlane 是一个资源网格

使微服务能够在整个企业中创建、查找、监视和使用各种微资源以及向其他微服务发送消息。 Starlane 还提供了用于部署、执行和连接客户端和服务器端 WebAssembly 参与者(称为 Mechtrons)的机制。

Starlane 使在云、边缘、桌面、移动和物联网环境中安全的 WebAssembly 代码的部署和互操作变得容易。

Youki v0.0.3 版本更新,增加 WASM 支持

youki 是一个 Rust 实现的容器运行时,是 OCI 运行时规范的实现,类似于 runc。此次 0.0.3 版本带来了 wasm 支持。

https://github.com/containers/youki

去容器化! 如何在 k8s 上借助 Rust 运行 Wasm

Wasm 是当下最火热的技术之一,作者介绍了如何将其与 K8s 结合起来,同时说明了为何 Rust 是最适合开发 Wasm 的语言。

https://developer.okta.com/blog/2022/01/28/webassembly-on-kubernetes-with-rust

游戏与图像处理

Bevy 0.6 发布

Bevy 目前还未稳定,所以版本更新会出现 break change的情况。升级需要看0.5 到 0.6 迁移指南。

0.6 版本改进:

- 一个全新的现代渲染器,更漂亮、更快速、更容易扩展

- 方向性和点状光影

- 集群式向前渲染

- 锥体裁剪剔除

- 以更少的模板大幅提高精灵的渲染速度

- 本地WebGL2支持。你可以在你的浏览器中运行Bevy的例子来测试这一点

- 更方便地自定义材质

- 更强大的着色器:预处理器、导入、WGSL支持

- Bevy ECS的人机工程学和性能改进。不再有

.system()! - 健全性和正确性的改正。

重点摘要:ECS 改进

Bevy ECS 的最优先准则是 人体工程学(ergonomics),即,开发体验要符合人类的习惯。Bevy 开发者们花了大量的精力来做到这一点。

- 消除 system 方法调用

这是 0.5 版本增加 System 的示例:

// This is a standalone Bevy 0.5 App that adds a simple `gravity` system to the App's schedule

// and automatically runs it in parallel with other systems

fn main() {

App::build()

.add_plugins(DefaultPlugins)

.add_system(gravity.system())

.run();

}

fn gravity(time: Res<Time>, mut query: Query<&mut Transform>) {

for mut transform in query.iter_mut() {

transform.translation.y += -9.8 * time.delta_seconds();

}

}

这是0.6的改进,完全去掉了 .system()。

// pure bliss!

App::new()

.add_plugins(DefaultPlugins)

.add_system(gravity) // 不需要调用 .system()

.run();

- 改进组件trait和增加

#[derive(Component)]

在Bevy 0.6中,类型不再默认实现 Component trait。在过去的版本中,通过下面这样一揽子(blanket impl)的实现为所有类型实现了 Compont trait 。

impl<T: Send + Sync + 'static> Component for T {}

但是在对Bevy ECS有深刻理解及对未来计划有很大变化之后,发现这样的设计存在以下问题:

- 不是所有的东西都应该是组件。新用户不小心将捆绑类型和类型构造器添加为组件是在Bevy Discord上最常见的

#help channel threads,这类错误是很难调试的。 - 如果我们对所有东西都自动实现了Component,我们就不能用相关的类型来定制Component类型。这就阻止了整类的优化。例如,Bevy ECS现在有多种Component存储类型。通过将存储类型移到Component中,我们使rustc能够优化通常需要在运行时进行的检查。

- 自动注册。将更多的逻辑转移到Component中,也使我们有能力在未来做更多的事情,比如 "在派生Component时自动注册反射"。

- 其他等,官网查看细节。

现在可以通过派生宏自动实现,也可以手动实现 Component。

// defaults to "Table" storage

#[derive(Component)]

struct SomeComponent;

// overrides the default storage

#[derive(Component)]

#[component(storage = "SparseSet")]

struct SomeComponent;

更多细节: https://bevyengine.org/news/bevy-0-6/

vange-rs: 是对一款具有独特玩法和技术创新的传奇游戏Vange的Rust重新实现

该项目是由wgpu-rs作者 kvark 实现的。

技术栈:

该游戏使用wgpu-rs进行图形处理,使用winit进行窗口化。

关卡是在单个全屏绘制调用中绘制的,带有一点光线追踪魔法。还有一个实验性的基于曲面细分的渲染器,但都没有产生足够质量的结果。请参阅渲染技术的专用 wiki 页面。

注意:该项目依赖于原版游戏的素材,所以需要你自己在GOG购买该游戏(28元)才能跑,而且不支持 macosx m1。

Bevy 渐变动画插件发布新版本

https://github.com/djeedai/bevy_tweening

Sandbox - 像素物理模拟器

Sandbox 是一个像素物理模拟器,灵感来自Sandspiel和Noita等其他模拟器。

- 使用Vulkano的 Vulkan 渲染器

- Gui 与Egui使用egui_winit_vulkano

- 使用计算着色器进行细胞自动机模拟

- .png来自图像的可变形像素对象

- 简单的物理引擎 Rapier

https://github.com/hakolao/sandbox

Paudle: 使用Yew编写的类似Wordle的猜字谜游戏

Paudle是对Josh Wardle的优秀文字游戏Wordle的重新实现。这个版本是用Yew和Rust制作的。作者仿照了Wordle的颜色和布局(当然还有游戏逻辑),但实现都是原创的。 与最初的版本不同,这一版本完全是基于客户端的,因此没有什么可以阻止你作弊——如果你能找出如何从运行的WASM中提取当前单词的话。

关于Wordle:

Wordle 和填字游戏都属于字谜游戏的一种。

这个游戏每天更新一期,玩家唯一目标,就是在六次尝试机会之内,猜出一个五个字母的单词。 为此,游戏界面是一个 5×6 的方块阵列。玩家通过下方键盘输入猜测结果后,游戏会给字母方块标上颜色,提示猜测的准确性:

- 绿色 🟩:说明答案里有这个字母、所在位置也正确;

- 黄色 🟨:说明答案里有这个字母、但不在这个位置;

- 灰色 ⬜️:说明答案里没有这个字母。

然后,玩家根据获得的提示继续尝试,直到猜对答案,或者用尽六次机会。

https://github.com/pmsanford/paudle

劲爆!doukutsu-rs - 洞穴物语完全重制版

https://github.com/doukutsu-rs/doukutsu-rs

Veloren 0.12 发布!

Veloren是一个rust实现的多人像素RPG游戏,Veloren从Cube World、Minecraft这些游戏获取灵感,目前还处在开发阶段,但是已经是可玩的了。

https://github.com/veloren/veloren

godot-rust 0.10 版本发布

godot-rust是一个Rust库,为Godot游戏引擎实现本地绑定。这允许你在Godot中开发游戏或其他应用程序,同时受益于Rust的优势,如其类型系统、可扩展性和性能。

https://github.com/godot-rust/godot-rust

开源观察 | 操作系统

用 Rust 实现的低级 NTFS 文件系统库

NTFS是所有 Windows 版本中的主要文件系统(从 1993 年的 Windows NT 3.1 开始)。此板条箱适用于 Windows 2000 到当前 Windows 11 中使用的 NTFS 3.x 版本。

crate 是no_std兼容的,因此可用于从固件级代码到用户模式应用程序。

Rust for Linux 第四次补丁提审

补丁的具体细节可以在Linux 邮件列表中找到:

- RFC: https://lore.kernel.org/lkml/20210414184604.23473-1-ojeda@kernel.org/

- v1: https://lore.kernel.org/lkml/20210704202756.29107-1-ojeda@kernel.org/

- v2: https://lore.kernel.org/lkml/20211206140313.5653-1-ojeda@kernel.org/

- v3: https://lore.kernel.org/lkml/20220117053349.6804-1-ojeda@kernel.org/

第二次补丁改进摘要可参考:Rust for Linux 源码导读 | Ref 引用计数容器。

第三次补丁改进摘要:

- 对 Rust 的支持有一些改进:

- 升级到 Rust 1.58.0

- 增加了自动检测来判断是否有合适的 Rust 可用工具链(

CONFIG_RUST_IS_AVAILABLE,用于替换HAS_RUST) - 移除

!COMPILE_TEST - 其他构建系统的改进

- 文档改进

- 需要的不稳定功能之一,

-Zsymbol-mangling-version=v0,在 1.59.0 中变得稳定。另一个,“maybe_uninit_extra”,将在 1.60.0 中。

- 对抽象和示例驱动程序的一些改进:

- 加了将在总线中使用的“IdArray”和“IdTable”,以允许驱动程序指定在编译时保证为零终止(zero-terminated)的设备 ID 表。

- 更新了

amba以使用新的常量设备 ID 表支持。 - 初始通用时钟框架抽象。

- 平台驱动程序现在通过实现特质(trait)来定义。包括用于简化平台驱动程序注册的新宏和新示例/模板。

dev_*打印宏。IoMem<T>的{read,write}*_relaxed方法。- 通过删除

FileOpener来简化文件操作。 - 在驱动程序注册的参数中添加了“ThisModule”。

- 添加用 Rust 编写的树外 Linux 内核模块的基本模板: [https ://github.com/Rust-for-Linux/rust-out-of-tree-module](https ://github.com/Rust-for-Linux/rust-out-of-tree-module)

第四次补丁改进摘要:

- 基础设施更新:

- 整合 CI : 英特尔 0DAY/LKP 内核测试机器人 / kernelCI/ GitHub CI

- 内核模块不需要写 crate 属性,

#![no_std]和#![feature(...)]不再存在,删除样板。 - 添加了单目标支持,包括

.o、.s、.ll和.i(即宏扩展,类似于 C 预处理源)。 - 对

helpers.c文件的解释和对helpers的许可和导出的许可。 - 文档Logo现在基于矢量 (SVG)。此外,已经为上游提出了 Tux 的矢量版本,并且用于改进自定义Logo支持的 RFC 已提交至上游 Rust。

- 添加了关于注释 (

//) 和代码文档的编码指南(///)。 is_rust_module.sh返工。- 现在跳过了叶子模块的

.rmeta的生成。 - 其他清理、修复和改进。

- 抽象和驱动更新:

-

增加了对静态(全局共享变量)同步原语的支持。

CONFIG_CONSTRUCTORS被用于实现。 -

通过使用标记类型简化了锁防护,即

Guard和GuardMut统一为一个参数化的类型。如果标记是WriteLock,那么Guard就会实现DerefMut(以前只由GuardMut实现)。 -

可选参数添加到杂项设备(misc device)的注册中。遵循构建者模式,例如:

#![allow(unused)] fn main() { miscdev::Options::new() .mode(0o600) .minor(10) .parent(parent) .register(reg, c_str!("sample"), ()) } -

增加了 "RwSemaphore "的抽象,该抽象包裹了C端

struct rw_semaphore。 -

新的

mm模块和VMA抽象(包装C端struct vm_area_struct)用于mmap。 -

GPIO PL061现在使用最近增加的

dev_*!Rust宏。 -

支持

!CONFIG_PRINTK情况。 -

其他清理、修复和改进。

-

kerla:用 Rust 编写的具有 Linux ABI 兼容性的新操作系统内核

Kerla 是一个用 Rust 从头开始编写的操作系统内核,旨在与 Linux ABI 兼容,也就是说,它无需任何修改即可运行 Linux 二进制文件。

-

实现 *NIX 进程概念:上下文切换、信号

fork(2)、execve(2)、wait4(2)等。 -

支持常用的系统调用,如

write(2),stat(2),mmap(2),pipe(2),poll(2), ... -

目前不支持磁盘:

initramfs被挂载为根文件系统。 -

伪文件系统:

tmpfs和devfs。 -

基于

smoltcp的 TCP/IP 支持。 -

实现

tty和伪终端 (pty)。 -

支持 QEMU 和 Firecracker(带有 virtio-net 设备驱动程序)。

-

支持 x86_64。

-

基于 Docker 的 initramfs 构建系统。

snarkOS: 去中心化操作系统

snarkOS是一个用于私有应用程序的去中心化操作系统。它构成了Aleo的主干,使应用程序能够以可公开验证的方式验证和存储状态。

https://github.com/AleoHQ/snarkOS

Aero : Rust 编写的新的现代、实验性、类似 unix 的操作系统

这是 Linux 发行版吗? 不,Aero 运行自己的内核,该内核并非源自 Linux,并且不与 Linux 内核共享任何源代码或二进制文件。

Aero 遵循单片内核设计,并受到 Linux 内核的启发。Aero 支持现代PC 功能,例如长模式、5 级分页和 SMP(多核)等。

目标:

- 打造现代、安全、美观、快速的操作系统。

- 针对现代 64 位架构和 CPU 功能。

- 与 Linux 良好的源代码级兼容性,因此我们可以轻松地移植程序。

- 制作一个可以在真实硬件上运行的可用操作系统,而不仅仅是在模拟器或虚拟机上。

Aero 使用自定义构建系统,它包装了Cargo 负责构建内核和用户空间。它还构建 initramfs 和磁盘映像。

https://github.com/Andy-Python-Programmer/aero

Rust 与 NuttX 操作系统

Apache NuttX OS 是一个实时嵌入式操作系统 RTOS,可在许多平台(如:8 位到 64 位平台)上移植,并且像 Linux 的小型版本一样工作(因为它符合 POSIX 标准)。现在,我们可以在 NuttX 上使用 Rust 创建更安全的嵌入式应用程序,也可以定制自己的驱动程序。

在所有嵌入式操作系统中,Apache NuttX 是真正独一无二的,因为……

- NuttX 在8 位、16 位、32 位和 64 位微控制器上运行……跨越RISC-V、Arm、ESP32、AVR、x86等流行平台

- NuttX严格遵守 POSIX。这意味着 NuttX 应用程序应通过调用

open()、read()、write()、ioctl()来访问微控制器硬件……(看起来像 Linux Lite!) - 对于BL602 和 BL604:NuttX 和 FreeRTOS 是 Bouffalo Lab 的 RISC-V + WiFi + 蓝牙 LE SoC 上唯一支持的操作系统。

NuttX 以其创建者Gregory Nutt的名字命名。X,因为它符合 POSIX 标准。

https://lupyuen.github.io/articles/rust2

使用 crosvm 在 Rust 中实现应用程序和操作系统虚拟化

虽然 QEMU 仍然是开源 VMM(虚拟机管理器)的首选,但 Rust 替代品可能对安全性很有帮助。

现在可以通过修改 crosvm 来虚拟化 Linux 中的 GUI 应用程序和操作系统,这是一个基于 rust 的出色开源 VMM,由 Google 开源。

- https://blog.openw3b.org/crosvm-for-os-and-app-virtualization-on-linux/

- https://google.github.io/crosvm/

KDE 正在为 KConfig 开发一个 Rust wrapper

Ayush Singh 将为 KConfig 开发一个 Rust wrapper 。有了这个 wrapper ,以及针对 qmetaobject 和 ki18n 的现有 wrapper ,在 Rust 中开发 KDE 应用程序将变得更加容易。可以在 kde-devel 邮件列表中找到更多信息。

snarkOS: 去中心化操作系统

snarkOS是一个用于私有应用程序的去中心化操作系统。它构成了Aleo的主干,使应用程序能够以可公开验证的方式验证和存储状态。

https://github.com/AleoHQ/snarkOS

Linux RamFS文件系统移植到Rust

RamFS是Linux中基于Ram的文件系统。它被描述为一个简单的文件系统,用于学习创建新的Linux文件系统(link)所需的最小实现。

在2021年秋季与弗吉尼亚理工大学的张宇民博士一起学习高级 Linux 内核编程。Connor Shugg 和我(Chase Minor)将它从c移植到Rust,以了解移植到内核内部的过程。我们在这里提供我们的资源和知识,以供使用,包括或学习。

我们工作的主要贡献是RAMFS文件系统的移植。但是,我们也向内核添加了各种其他东西,这可能对其他使用Rust的Linux开发人员有益。

- https://github.com/acminor/linux/tree/ramfs-rust/fs/ramfs_rust

- https://austincminor.com/20211030000942-ramfs_rust.html

PopOS正在与Relm4配合,以帮助用Rust在PopOS上开发GTK程序

PopOS是要开发Rust Linux发行版的System76的Linux发行版,现在正致力于和Relm4合作,帮助用Rust在PopOS上更容易地开发GTK程序。

Relm4是基于GTK上层的一套框架,提供类Elm的编程模式。

https://www.reddit.com/r/rust/comments/sxwi46/popos_collaboration_with_relm4_writing_gtk/

【视频】Miguel & Wedson:Rust for Linux 当前状态

Rust for Linux 是一个旨在将 Rust 支持作为头类语言引入 Linux 内核的项目。这意味着为用 Rust 编写内核模块(例如驱动程序或文件系统)提供支持,并且使用尽可能少的不安全代码。

本次会议将简要解释 Rust 支持如何在内核中工作,并将提供项目状态的更新,以及近期的计划。它还显示可以帮助该项目的 Rust 功能的愿望清单。

Youtube链接:https://www.youtube.com/watch?v=fVEeqo40IyQ

RustSBI软件发布v0.2.2版本

洛佳发布了RustSBI 0.2.2版本。RustSBI现已支持最新的RISC-V SBI 1.0.0正式批准版的规范标准。另外,本次更新预留了主从机不同的指针宽度,准备为虚拟化软件提供SBI接口实现支持。

相比0.2.0版本,新版修复了一个较为严重的逻辑漏洞,推荐0.2.0版本用户立即更新。

RISC-V SBI是RISC-V桌面与服务器平台不可或缺的基础软件,而RustSBI是RISC-V SBI标准采纳的软件实现之一。RustSBI完全由嵌入式Rust编写,自从2020年RustSBI发布第一个版本以来,软件久经考验,是成熟的RISC-V内核支持接口实现。

https://github.com/rustsbi/rustsbi/releases/tag/v0.2.2

stardust-oxide - 基于 Rust 的 Unikernel

基于 Rust 的 Unikernel。

- 支持日志的控制台驱动程序

- 页框映射和表生成

- 授予表创建/销毁

- XenStore 界面

- XenBus 接口

- 简单的异步执行器

https://github.com/StardustOS/stardust-oxide

命令行工具

adsb_deku: Rust 实现的终端雷达应用

基于 tui-rs,实现在终端即可解码 ADS-B 来监视飞越你家的飞机

ADS-B : 广播式自动相关监视

“ADS-B 是一种空中交通监视应用,用于传递飞行参数,比如,位置,航迹和 地速等,通过数据链广播模式,在特定的间隔时间内发送,任何空地用户 都可以申请使用这个功能。” (ICAO国际民航组织)

- ADS-B RAD : 广播式自动相关监视 可用于雷达覆盖空域

- ADS-B NRA : 广播式自动相关监视 可用于无雷达覆盖空域

- ADS-B APP : 广播式自动相关监视 可用于机场地面活动区交通监视

https://github.com/rsadsb/adsb_deku

cargo-mobile: 帮助你在 iOS 和 Andriod 上方便地使用 Rust

这个工具是对 “如何在 iOS 和 Andriod 上使用 Rust ?” 问题的回应。

cargo-mobile 是一个与框架无关的工具,可以生成 Xcode 和 Android Studio 项目文件、在设备上构建和运行、生成项目样板文件以及其他一些事情!目前支持 macOS 和 Linux 。

该工具在 BrainiumLLC 公司内部已经使用了,可以看其公司博客介绍。注意,这篇文章是两年前的了,但是工具是刚开源,文章还未来得及更新。

cargo install --git https://github.com/BrainiumLLC/cargo-mobile

https://github.com/BrainiumLLC/cargo-mobile

argc: 一种处理 sh/bash 命令参数的便捷方式

# demo.sh

# @describe A demo cli

# @cmd Upload a file

# @arg target! File to upload

upload() {

echo "cmd upload"

echo "arg: target $argc_target"

}

# @cmd Download a file

# @flag -f --force Override existed file

# @option -t --tries <NUMBER> Set number of retries to NUMBER

# @arg source! Url to download from

# @arg target Svae file to

download() {

echo "cmd: download"

echo "flag: --force $argc_force"

echo "option: --tries $argc_tries"

echo "arg: source $argc_source"

echo "arg: target $argc_target"

}

eval "$(argc -e $0 "$@")"

用 Argc 编写命令行程序,只需要做两件事:

- 在注释中描述选项、参数和子命令

- 调用

eval命令委托Argc为我们处理命令行参数

Argc 根据标签(@注释中标记的字段)生成解析规则和帮助文档。

https://github.com/sigoden/argc

Pijul 1.0 beta 发布

Pijul 是一个免费的开源 (GPL2)分布式版本控制系统。

经过了 53 个alpha版本的Pijul 1.0 beta终于发布了

获取系统信息的命令行工具汇总

neofetch是一个用bash 3.2+编写的命令行系统信息工具;

以下是一些使用Rust编写的命令行工具的替代品:

- ferris-fetch - A system information tool for Rustaceans.

- freshfetch - A fresh take on neofetch.

- fsi - FSI (Fetch System Info) cli tool written in Rust.

- macchina - A system information fetcher, with an emphasis on performance and minimalism.

- onefetch - Git repository summary on your terminal.

- rfetch - A fast and minimal fetch program.

- rsfetch - A WIP rewrite of rsfetch from scratch.

- scrftch - Screenfetch in Rust.

Puff——一个基于Rust的CLI工具,用于将应用程序的配置存储在一个公共位置,以便轻松传输到另一台机器

Puff是一个CLI工具,用于管理正在开发的应用程序的配置文件。通常,这些配置与项目的源代码一起使用。由于它们可能包含的密码/密钥,它们通常被排除在版本控制系统之外。Puff管理这些文件并将它们存储在一个公共位置,从而更容易将它们传输到另一台开发机器。你的应用程序通过Puff创建的符号链接访问配置文件。

jless:命令行 JSON 查看器

JLess 是一个命令行 JSON 查看器,专为阅读、探索和搜索 JSON 数据设计。

- 美化输出 JSON 并附加语法高亮。适合在探索外部 API 或调试请求有效载荷时使用。

- 展开/折叠对象和数组,有助于掌握 JSON 文档的高级/低级结构。得益于大量受 Vim 启发的命令,探索数据变得轻而易举。

- 支持基于表达式的全文搜索。能够在长字符串值中快速查找数据,或者在相同对象键之间跳转。

https://github.com/PaulJuliusMartinez/jless

zellij - tmux 的 Rust 实现版本

Zellij是一个面向开发人员、面向运维的人员和任何喜欢终端的人的工作区。它的核心是一个终端多路复用器(类似于tmux和screen),但这仅仅是它的基础设施层。

Zellij 包括一个布局系统和一个插件系统,允许人们以任何可以编译为 WebAssembly 的语言创建插件。

https://github.com/zellij-org/zellij

Zee - Rust编写的终端编辑器

Zee 是一个现代的终端编辑器,由 Rust 编写。

https://github.com/zee-editor/zee

Fig.io 使用 Rust 重写其 CLI

Fig 为现有终端添加 IDE 风格的自动补全。

此前,Fig 是一个捆绑了 CLI 的桌面 App 。而现在,Fig 用 Rust + Clap 进行了重现,变成一个可以添加到桌面 App 中的 CLI 工具。这意味着:

跨平台体验,支持 Linux 和 Windows,更好的性能 在远程计算机上运行 发布酷炫的新产品 同时,Fig 也为 Rustacean 提供 System Engineer 职位。

xshell: 0.2 版本发布

xshell提供了一套跨平台实用工具,用于编写跨平台和符合人体工程学的 bash 脚本。

https://github.com/matklad/xshell

igrep - 交互式grep

https://github.com/konradsz/igrep

开源观察 | 性能工具

Rust Benchmarks 小技巧

为什么你的 Rust Benchmark 可能出现问题,如何正确使用标准库中的 std::hint::black_box 呢? Gendignoux 在一篇文章中分享了他在深入挖掘Benchmark 出现的问题之后得出的结论。

https://gendignoux.com/blog/2022/01/31/rust-benchmarks.html

字符串连接操作的基准测试

基于 Hendrik Sollich 在 4 年前的工作,作者添加了一些常用的函数和宏的基准结果:

#![allow(unused)] fn main() { 0 ns/iter (+/- 0) from_bytes 10 ns/iter (+/- 0) concat_string_macro 10 ns/iter (+/- 0) concat_strs_macro 10 ns/iter (+/- 0) mut_string_with_capacity_push_str_char 10 ns/iter (+/- 0) string_concat_macro 10 ns/iter (+/- 1) mut_string_with_capacity_push_str 14 ns/iter (+/- 0) concat_in_place_macro 19 ns/iter (+/- 10) mut_string_with_too_much_capacity_push_str 22 ns/iter (+/- 0) array_join 24 ns/iter (+/- 0) array_concat 24 ns/iter (+/- 0) array_join_long 24 ns/iter (+/- 0) mut_string_push_str 27 ns/iter (+/- 0) string_from_plus_op 27 ns/iter (+/- 0) to_string_plus_op 29 ns/iter (+/- 0) to_owned_plus_op 30 ns/iter (+/- 0) collect_from_array_to_string 34 ns/iter (+/- 0) collect_from_vec_to_string 39 ns/iter (+/- 0) mut_string_with_too_little_capacity_push_str 43 ns/iter (+/- 1) string_from_all 52 ns/iter (+/- 0) format_macro 53 ns/iter (+/- 0) format_macro_implicit_args 68 ns/iter (+/- 1) mut_string_push_string }

https://github.com/hoodie/concatenation_benchmarks-rs

开源观察|网络基建

gRPC 压测结果报告

这个压测报告整合了很多语言的 gRPC 库,包括 Rust ,表现不俗。

https://github.com/LesnyRumcajs/grpc_bench/wiki/2022-01-11-bench-results

开源观察 | Web开发

Rust Web 框架

Rust社区有很多 Web 框架库,参考《Web Frameworks》以及《Which Rust web framework to choose in 2022 (with code examples)》,补充整理以后总表如下:

| 库 | 总下载量 | 介绍 / 部分特性 |

|---|---|---|

| actix-web | 5,134,720 | HTTP / 1.x,HTTP / 2 兼容 Tokio 支持压缩和解压 Openssl 或 Rustls 支持 中间件 (Logger, Session, CORS, etc) 兼容 Rust 1.54+ |

| warp | 4,222,391 | 实现路由和参数提取功能 实现头请求以及提取功能 实现请求字段反序列化功能 支持 Gzip, Deflate, and Brotli 压缩 基于 hyper 编写,支持 HTTP / 1.x,HTTP / 2,Async |

| rocket | 1,471,930 | 需要 nightly Rust |

| iron | 1,018,360 | 基于 hyper 编写,支持 HTTP / 1.x,HTTP / 2,Async 支持并行运行 支持负载平衡 |

| tide | 491,651 | 支持异步 |

| axum | 276,608 | 实现路由功能 基于 hyper 实现 基于 tower 和 tower-http 生态实现,可利用其中中间件、服务以及实用程序 |

| nickel | 205,611 | 简易轻量Rust web 框架支持 |

| gotham | 91,435 | 支持异步 |

| poem | 54,160 | 兼容 tower::Service 以及 tower::Layer 支持压缩与解压 |

| thruster | 25,521 | 支持异步 兼容 hyper 支持 ssl 支持 gRPC |

WebAssembly 前端库表如下:

| 库 | 总下载量 | 介绍 / 部分特性 |

|---|---|---|

| yew | 239,796 | 使用 WebAssembly 来创建多线程的前端 web 应用,支持与 JavaScript 交互 |

| seed | 138,857 | 前端 Rust 框架,可创建类似于 elm 架构的 web 程序,不需要 nightly 版本 |

| iced | 106,406 | 跨平台 GUI 库 |

| sauron | 24,648 | 可用于服务端或客户端开发,适用于开发使用渐进式渲染的 Web 应用程序 |

| mogwai | 3,213 | GUI 库 |

| percy | 397 | / |

对于 actix-web,warp,axum 这三个库,《Which Rust web framework to choose in 2022 (with code examples)》文中比较总结如下:

| 库 | Github Stars | Json 序列化以及反序列化 | 路由 (Routing) | 中间件 (Middleware) | 数据共享 (State) |

|---|---|---|---|---|---|

| actix-web | ~13.3k | 支持 | 相对支持最差 | 支持 | 支持 |

| warp | ~6k | 支持 | 支持 | 相对支持最好 | 支持 |

| axum | ~3.6k | 支持 | 相对支持最好 | 支持 | 支持 |

参考

Which Rust web framework to choose in 2022 (with code examples),https://kerkour.com/rust-web-framework-2022

Web Frameworks,https://www.arewewebyet.org/topics/frameworks/

Actix Web 发布 v4.0

Actix Web 是一个强大的高性能 Web 框架,用于创建从小型到单体的 Web 服务。

v4.0 版本是由社区推动的,57 位贡献者提交了超过 600 次!主要变化包括:

- 完全兼容 Tokio v1 生态系统,包括#[tokio::main] 支持。

- 使 actix-http 更精简。这个 crate 支持 Actix Web,包含我们的 HTTP/1 实现和较低级别的 HTTP 处理。

- API 改进,通常是为了提高表现力和开发人员的生产力。

- 减少特定 API 中的 paper-cuts 和 non-obvious 行为的数量。

- 大大改进了大量关键项目的文档。

迁移指南包含了如何更新的解释和差异。

热议 - 2022 年你会选择哪种 Web 框架

Sylvain Kerkour ,Bloom 的创建者也是 Black Hat Rust 一书的作者,发文对比了 actix-web、warp 和 axum 三个 Web 框架,结合代码示例进行了一个简单的评估。尽管作者心属 axum,但还是选择 actix-web 作为 Bloom 的首选。

Reddit 上的网友则提供了更多讨论,包括 tide ,rocket 以及 poem 。

https://www.reddit.com/r/rust/comments/szl0im/which_rust_web_framework_to_choose_in_2022_with/

axum-auth: HTTP auth extractor

提供 Axum 下的 HTTP auth extractor. 支持 Bearer 和 Basic Auth.

https://github.com/Owez/axum-auth

如何使用axum的 "Type safe routing"?

一篇讲解axum的博文:

https://mixi-developers.mixi.co.jp/how-to-use-type-safe-routing-of-axum-c06c1b1b1ab

移动开发领域

cargo-mobile :提升 Rust 在移动开发领域体验的便利工具

cargo-mobile 是一个与框架无关的工具,可以生成 Rust 移动项目的所有样板文件,并且包含大量用于在移动设备上构建和运行的便捷命令。

目前仅支持 macOS 和 Linux 。

https://github.com/BrainiumLLC/cargo-mobile

cargo-xcodebuild: 编译和运行 iOS 的 apps

让 cargo 编译和运行 iOS 的 apps.

例如, 只要很小的改动,就可以使用 xcodebuild 来运行 bevy/miniquad/wgpu/etc..

[lib]

crate-type = ["staticlib"]

[package.metadata.ios]

build_targets = ["aarch64-apple-ios", "aarch64-apple-ios-sim", "x86_64-apple-ios"]

在 lib.rs 中

#[no_mangle] pub extern "C" fn main_rs() { // start game code here }

运行步骤:

- 启动一个模拟器

cargo xcodebuild run

https://github.com/Gordon-F/cargo-xcodebuild

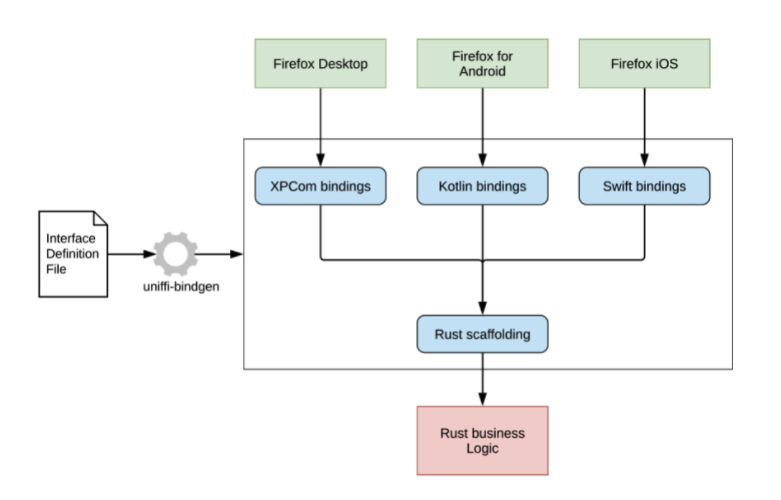

swift-bridge 促进 Rust 和 Swift 互操作

可以在 Rust 和 Swift 之间传递和共享高级类型,例如 Option

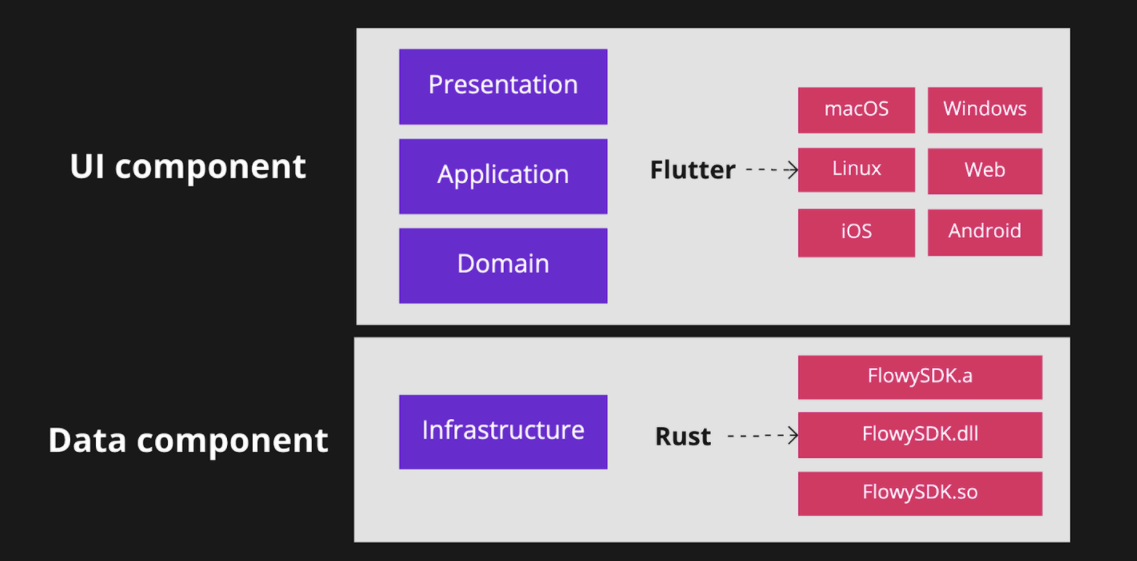

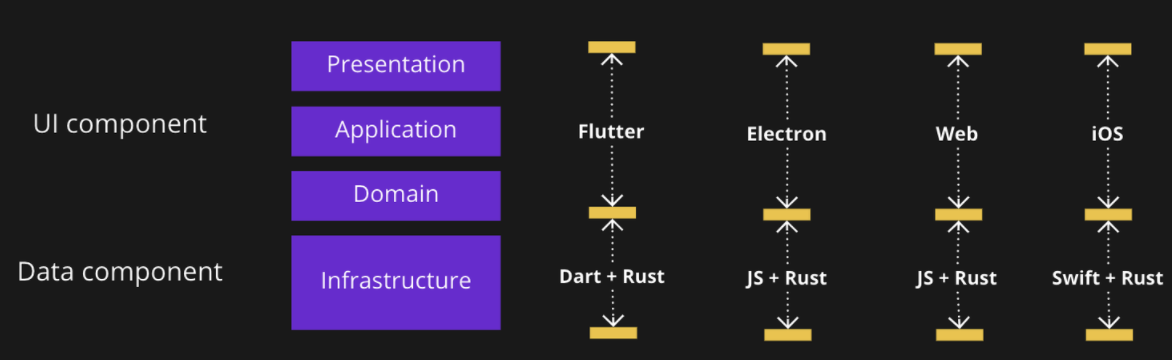

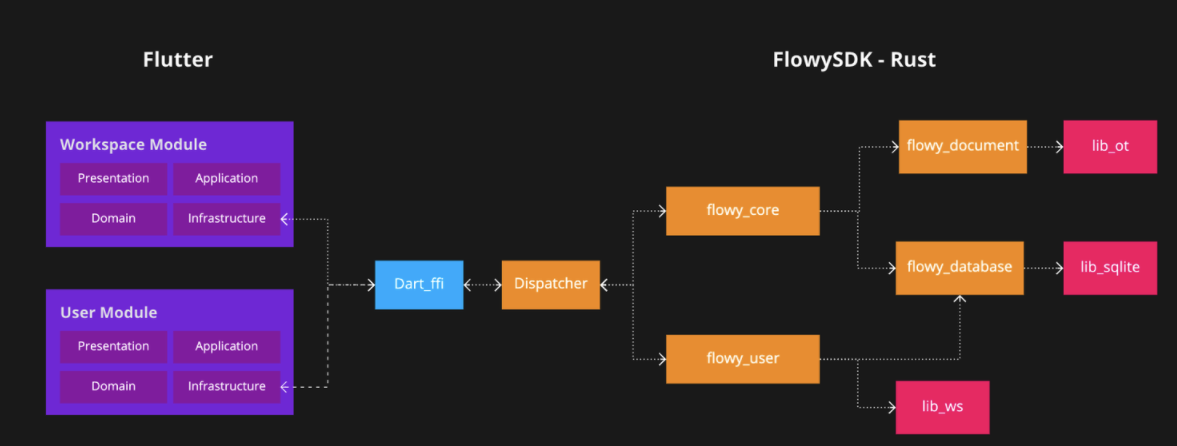

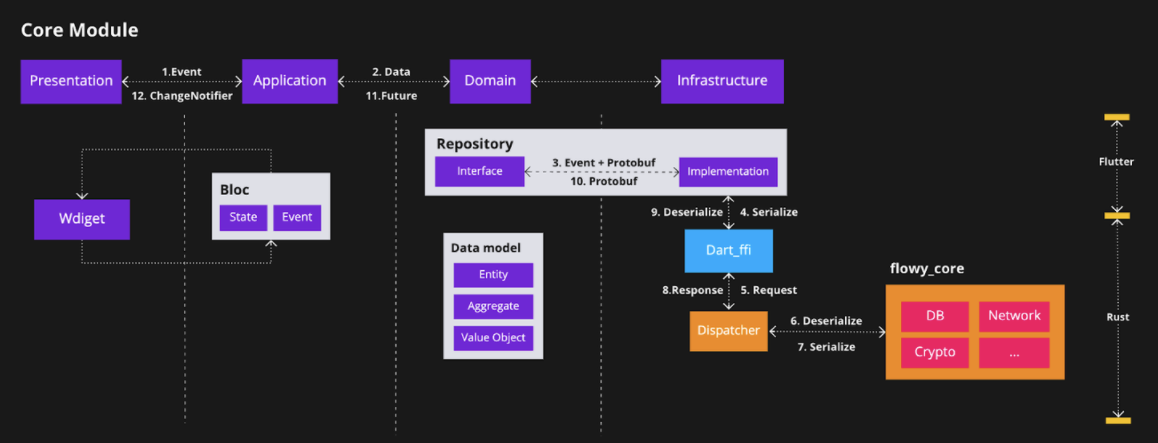

flutter_rust_bridge 一个用于 Flutter/Dart 与 Rust 的高级内存安全绑定生成器

它开源将 Flutter(一种跨平台的热重载快速开发 UI 工具包)和 Rust(一种使每个人都能够构建可靠且高效的软件的语言)结合起来。

https://github.com/fzyzcjy/flutter_rust_bridge

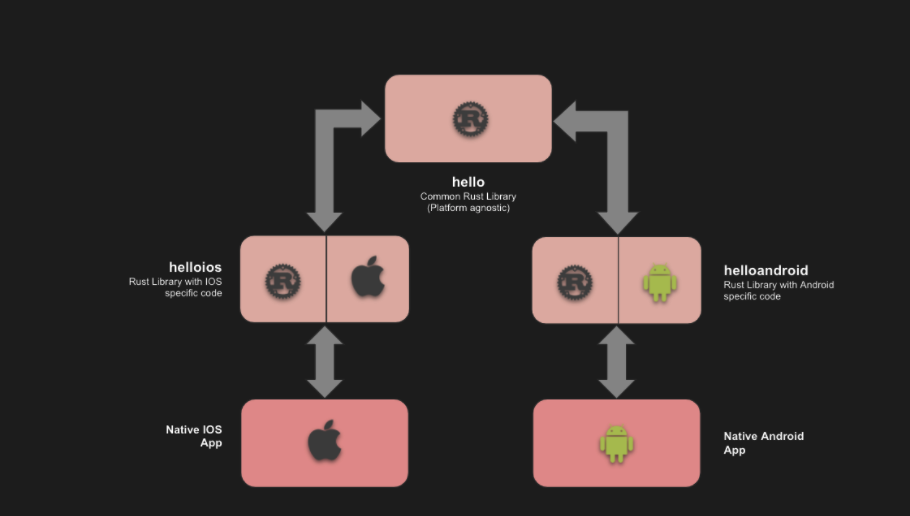

rust_android_ios寻找维护者

项目通过使用共享库来防止代码重复,保持完全原生的 UI 体验和对平台最新 API 的简单访问。它也非常灵活,允许在不同平台之间轻松迁移,包括传统的跨平台框架,如 Flutter 或 React Native。例如,您可以使用 Rust+React Native 或 Rust+Flutter 开发您的 MVP,然后迁移到原生 iOS/Android,而无需重写所有内容。 您甚至可以使用 WebAssembly 或桌面应用程序将您的核心重用于 Web 应用程序(同样,您可以使用本机或跨平台框架,如 Electron)。

如果你有意向,可以在项目上开个 Issue,或给作者发邮件:mailto:ivanhp978@gmail.com

https://github.com/ivanschuetz/rust_android_ios

开源观察 | 前端

我的Rust前端开发经历

作者使用Rust来开发一个音乐播放程序的前端。尝试了Seed和Dioxus。把使用过程记录了下来。

https://blog.urth.org/2022/02/08/my-rust-frontend-experiences/

音视频处理

gyroflow: 可以根据来自陀螺仪和可选的加速度计的运动数据来稳定视频

现代相机在内部记录这些数据(GoPro、Sony、Insta360 等),并且此应用程序通过使用它们来精确稳定捕获的镜头。它还可以使用来自外部源(例如来自 Betaflight blackbox)的陀螺仪数据。

用它可以省下买大疆手持稳定器的钱?

支持的陀螺源:

- GoPro(HERO 5 及更高版本)

- 索尼(a1、a6600、a7c、a7r IV、a7 IV、a7s III、a9 II、FX3、FX6、RX0 II、RX100 VII、ZV1、ZV-E10)

- Insta360 (OneR, SMO 4k, GO2)

- Betaflight 黑盒(CSV 和二进制)

- 移动应用程序:Sensor Logger, G-Field Recorder,Gyro

- Runcam CSV(Runcam 5 橙色,iFlight GOCam GR)

- WitMotion(WT901SDCL 二进制文件和 *.txt)

支持Windows 10 64 位(1809 或更高版本)/ macOS 10.14 或更高版本(本机支持 Intel 和 Apple Silicon)/ Linux / 安卓9 等,具体请参考该项目仓库README文档。

技术栈:FFmpeg/QT/Wgpu/OpenGL/OpenCV

Kira 一个用于游戏开发的音频库

Kira 是一个跨平台库,用于为游戏创建富有表现力的音频。它提供了用于平滑调整声音属性的参数、用于将效果应用于音频的灵活混音器以及用于精确定时音频事件的时钟系统。

mmids: 多媒体摄取与分发系统

Mmids 是一个功能强大、用户友好、开源的实时视频工作流服务器。

OctaSine 0.6.0 发布:修复了主要的bug和一些其他变化

OctaSine 是用 Rust 编写的 VST2 频率调制合成器。

以前的版本有两个问题需要解决。一个是小型音频缓冲区处理不当,还有一个是笔记与样本的时间安排不正确。因为修复这些问题意味着改变音频输出,所以作者决定在同一版本中也做其他影响声音生成的更改和修复。

https://github.com/greatest-ape/OctaSine

GStreamer Rust bindings 0.18.0 发布了

GStreamer 是一个音视频框架库, gstreamer-rs 是他的 Rust binding, 目前 0.18.0 发布了.

https://gstreamer.freedesktop.org/news/#2022-01-16T11:00:00Z

fundsp:音频DSP库

FunDSP 是一个专注于可用性的音频 DSP(数字信号处理)库。

可用于:

- 游戏和应用程序的音频处理和合成

- 教育

- 音乐制作

- 声音 hacker 和音频 golfing

- DSP 算法原型

https://github.com/SamiPerttu/fundsp

Symphonia 发布 v0.5

Symphonia 是一个音频解码和媒体解复用库,支持 AAC、ALAC、FLAC、MKV、MP3、MP4、OGG、Vorbis、WAV 和 WebM 多种格式。类似 FFMpeg,不过是用纯 Rust 来实现的。

https://github.com/pdeljanov/Symphonia

gyroflow: 可以根据来自陀螺仪和可选的加速度计的运动数据来稳定视频

现代相机在内部记录这些数据(GoPro、Sony、Insta360 等),并且此应用程序通过使用它们来精确稳定捕获的镜头。它还可以使用来自外部源(例如来自 Betaflight blackbox)的陀螺仪数据。

用它可以省下买大疆手持稳定器的钱?

支持的陀螺源:

- GoPro(HERO 5 及更高版本)

- 索尼(a1、a6600、a7c、a7r IV、a7 IV、a7s III、a9 II、FX3、FX6、RX0 II、RX100 VII、ZV1、ZV-E10)

- Insta360 (OneR, SMO 4k, GO2)

- Betaflight 黑盒(CSV 和二进制)

- 移动应用程序:Sensor Logger, G-Field Recorder,Gyro

- Runcam CSV(Runcam 5 橙色,iFlight GOCam GR)

- WitMotion(WT901SDCL 二进制文件和 *.txt)

支持Windows 10 64 位(1809 或更高版本)/ macOS 10.14 或更高版本(本机支持 Intel 和 Apple Silicon)/ Linux / 安卓9 等,具体请参考该项目仓库README文档。

技术栈:FFmpeg/QT/Wgpu/OpenGL/OpenCV

开源观察 | Rust 与 其他编程语言

HVM: 基于 Rust 实现的用于大规模并行的最佳函数式运行时

HVM 全称 High-order Virtual Machine,高阶虚拟机,虽然只是一个原型,但性能优于 Haskell 的 GHC。HVM 的核心是一种非常简单的语言,类似于无类型的 Haskell。

HVM 采用最新的计算模型,即交互网络(Interaction Net)。该计算模型是图灵机(Turing Machine)和Lambda演算(Lambda Calculus)的结合,该模型的先前实现在实践中效率低下,然而,最近的一项突破大大提高了其效率,催生了 HVM。尽管是一个原型,但它在许多情况下已经击败了成熟的编译器,并且将朝着未知的性能水平扩展。

HVM 的运行时没有引用。相反,它具有一个.clone()成本为零的原语,直到需要时才会读取Clone的值(Lazy)。一旦完成,它不会被整个复制,而是逐层按需完成。换句话说,可以把 HVM 看作是一个将借用检查换做低成本Clone的 Rust。

特点:

frawk: 高效的类 awk 语言

frawk 是一种小型编程语言,用于编写处理文本数据的短程序。大致上,它是 AWK语言的一种实现。

类似于 awk:

awk - F','' NR > 1 { SUM += $2 } END { print SUM }'

这段代码可以对文件中的第二列求和:

Item,Quantity

Carrot,2

Banana,4

但是 frawk 性能更高。

leo-lang: 用于零知识应用的函数式、静态类型语言

该语言被用于专门构建私有应用程序。是 aleo 公司出品,配合该公司开源的去中心化操作系统 snarkOS。

rulex: 一个新的正则表达式语言

为什么要用 rulex?

正常的正则表达式非常简洁,但是当它们变得更长时,它们变得越来越难以理解。Rulex 用一种新的、更简单的语法解决了这些问题。Rulex 目前与 PCRE、JavaScript、Java、.NET、Python、Ruby 和 Rust 兼容。正则表达式风格必须在编译期间指定,因此 rulex 可以确保生成的正则表达式在目标正则表达式引擎上按需要工作。

https://github.com/Aloso/rulex

melody: 一种编译为ECMAScript正则表达式的语言

目的和 rulex 类似,为了提升正则表达式的可读性和易维护性

- https://github.com/yoav-lavi/melody

- 作者写了篇文章来记录用 Rust 实现语言的要点: https://blog.yoavlavi.com/takeaways-from-building-melody/

Glicol - 以图为导向的音乐实时编程语言

Glicol 可以帮助您使用代码制作音乐。您可以简单地连接不同的节点以形成循环,用 Rust 编写,得益于 WebAssembly,它可以在浏览器中丝滑运行。

将Ruby 的 JIT 编译器YJIT迁移到Rust

YJIT 是用于 Ruby 的 JIT 编译器,它采用了惰性基础块版本管理 (lazy Basic Block Versioning, LBBV) 架构。与当前的 CRuby 解释器相比,在进行实际基准测试时,YJIT 的平均速度大约提升了 23%。

现在YJIT团队希望探索使用Rust来帮助开发YJIT。而CRuby的其余部分将继续使用非Rust的工具链进行构建,而且构建Ruby应用时仍然支持YJIT开关。

价值主张:

- Rust的类型系统将尽早捕获更多的bug,有助于防止新的bug;

- 更易于管理日益复杂的YJIT;

- 更容易维护代码库;

- 对于新手来说更容易,因为编译器捕获了更多的bug;

- 更好的性能,因为我们可以实现更复杂的优化;

- 更容易添加对新平台的支持(这增加了复杂性);

- Rust拥有成熟且易于安装的工具,如源代码格式化程序和编辑器插件;

- Rust作为一个编程语言社区,其背后有着巨大的热情。这可以转化为对YJIT和Ruby的更大热情。

集成:

- YJIT将只依赖于Rust语言和标准库,而不依赖于其他依赖项;

- YJIT将能够在没有互联网连接的情况下进行构建;

- Rust对交叉编译有很好的支持;

- Rust在我们计划使用YJIT支持的所有平台(Mac、Linux、Windows)上都受支持;

- 已编译的CRuby二进制文件不会对共享库有任何新的依赖项;

- 在禁用YJIT的情况下,CRuby仍然可以在没有rustc的情况下进行构建

Ruby 之父 Matz 对此表态:“我可以使用 Zig 来实现 YJIT,只要解决了可预见的可移植性问题(如上所述)。 除此之外,作为一名长期的 C 程序员,我更喜欢 Zig 而不是 Rust,但这一切都取决于你。”

发起人回复:“在与团队进行更多讨论后,我们决定暂时继续使用 Rust。Rust 拥有如此庞大的爱好者社区这一事实是一个重要因素。这使得查找文档、帮助以及招聘人才变得更加容易。语言和生态系统的成熟也是一大优势。我本人非常偏爱 Zig,因为它有一些非常强大的功能(例如编译时代码执行),并且与 C 的互操作比与 Rust 的互操作要容易一些。然而,Zig 还没有达到 1.0 版本的事实对我们来说有点问题。”

完整的意见说明参阅:Porting YJIT to Rust (request for feedback)

Juliaup,Rust开发的 Julia 安装程序

Julia 即将推出安装程序 Juliaup,它由两个二进制文件组成:juliaup 和 julialauncher。juliaup 创建者在 Julia 更新计划中讲述了他为什么用 Rust 编写它。

juliaup 本身最初是用 Julia 编写的,然后使用 PackageCompiler.jl 进行编译。但这从来都不是一个真正顺利的体验,原因有很多。生成的二进制发行版非常庞大(几百 MB),这对于一个简单的小型命令行工具来说确实不理想,启动延迟不是很好(不可怕,但不是很好),编译时间真的很长,这一切都只是真的粗糙的。因此,在某个时候,当我已经将 julialauncher 移植到 Rust 时,我也将其余部分也移植了过来。我对这个选择非常非常满意,静态类型,非常不同的错误处理模型等,使其成为科学代码的完全非入门者,但对于像 Juliaup 这样的东西来说,它是一个非常好的匹配(比像 Julia、IMO 这样的动态语言要好得多)。—— juliaup creator: David Anthoff

https://discourse.julialang.org/t/plans-for-updating-julia/75880/15

Rust的动态语言扩展?

C语言程序员使用Lua来扩展他们应用程序的功能,Rust可以使用哪些类似的语言?

以下是一个可嵌入Rust代码中的脚本语言的汇总列表:

https://arewegameyet.rs/ecosystem/scripting/

rs-lisp:一个用Rust编写的小型lisp解释器

https://github.com/ktfth/rs-lisp

开源观察 | 嵌入式Rust

乐鑫芯片Rust 2022 第一季度进展报告

摘要:

- 使用内置的 esp-idf 构建系统来编译 esp-idf(称为“本机”构建)。

- 默认 esp-idf 版本提升为 v4.4。4.4 版有一些质量改进,以及一些功能。

- 编译器和Xtensa代码生成。Rust 一直是 Xtensa LLVM 后端的良好压力测试。团队在上个季度发现了一些对压缩很重要的错误,因为最终 esp-idf 将使用 clang 而不是 GCC 编译(希望到那时,clang将作为rustup 组件提供)。还修复了标准库端口的一些问题。

- 再见

esp-rs/esp32-hal,你好esp-rs/esp-hal。esp32 的原始 HAL 现在处于维护模式,一旦所有驱动程序都移植到新的多芯片 HAL,很快就会被弃用。 - 初步 WiFi 支持。

- espflash 1.4.0 版本即将发布,其中包含一些很棒的功能和修复。

- 发布了xtensa-toolchain,这是一个 Github Action,用于安装支持 Xtensa 的分叉 Rust 编译器。可以在此处找到有关如何使用的说明。

- 为了针对基于 Xtensa 的芯片(esp32、esp32s2、esp32s3 等),我们需要一个自定义的 rust 编译器,以及一个用于 Xtensa 的自定义 LLVM 后端。这给开始使用基于 Xtensa 的芯片增加了一些阻力。我们已经提供了用于下载预构建编译器工具链的脚本,但我们很高兴地宣布

esp-rs-devcontainer。它使用远程容器功能集成到 Visual Studio Code 中,允许已经熟悉容器的开发人员轻松设置。有关支持的配置和初始化步骤,请参阅设置部分。 - 开发了一个开源开发板,专注于为 Rust 开发做好准备,基于 RISCV esp32c3。如果想自己做一个开发板,可以看https://github.com/esp-rs/esp-rust-board

未来还有很多事情要做!

https://mabez.dev/blog/posts/esp-rust-04-04-2022/

科学艺术

科学计算

Slas v0.2.0 —— Rust静态线性代数系统

提供静态分配的向量、矩阵和张量类型,高效的实现了blas/blis接口,默认情况下使用写时复制行为(又名cow)。

与v0.1.1版本相比,新版本的Slas有很多突破性的变化和功能,包括:

- 模块化后端;

- 更好的性能;

- 支持矩阵和张量(张量仍然做不了多少);

- 向量支持可选的COW行为;

- 更好的基准测试和文档;

https://github.com/unic0rn9k/slas

Panther 一个用 Rust 和 Numpy C API 编写的高性能 python 技术分析库

平均而言,Panther 对一些常见指标的计算比使用 Pandas(行业标准方法)快 9 倍。

https://github.com/gregyjames/Panther

savage: Rust 编写的全新的计算机代数系统

Savage是一个全新的计算机代数系统,用纯Rust从头编写而成。它的目标依次是正确性、简单性和可用性。整个系统编译成一个单独的、没有依赖关系的可执行文件,大小只有2.5 MB。虽然这个可执行文件将随着Savage的成熟而增长,但他们的计划是最终交付一个有用的计算机代数系统,其大小不超过5 MB。

https://github.com/p-e-w/savage

生物信息学

什么是生物信息学?

生物信息学是信息与系统科学和生命科学高度交叉的前沿学科,是自动化学科群中的重要部分,包括计算生物学、系统生物学与合成生物学等方向。生物信息学涉及多个学科领域,信息、控制与系统的理论、方法和技术在其中发挥着重要作用,同时,它也把控制科学与工程的研究对象从机械、电子、物理、化学等系统扩展到了以分子和细胞为基本元件的生命系统。

- 生物信息学中计算机和大数据各扮演什么样的角色? https://www.zhihu.com/question/21476539

- 生物信息学学科发展报告 https://zhuanlan.zhihu.com/p/47508742

flopp: 用于基因定相的Rust实现的软件

用于从长读长测序中对多倍体生物进行单个单倍体定相。定相(Phasing)包括将每个染色体的父本母本遗传的拷贝分离成单倍型,以获得遗传变异的完整图谱。

定相在研究遗传变异领域非常重要,定相算法本身基本都是计算密集型的,做起来也比较耗时间,有时即使是在超算集群中也得跑很长时间。所以,Rust 语言应该是非常适合该场景。

flopp 非常快,多线程,并且完全用 rust 编程语言编写。与其他多倍体单倍体定相算法相比,flopp 提供了一个数量级的加速和更好的准确性。

什么是 定相(Phasing)?

Phasing,或者说Genotype Phasing,它的中文名有很多:基因定相、基因分型、单倍体分型、单倍体构建等在不同的语境下都有人说过。但不管如何,所谓Phasing就是要把一个二倍体(甚至是多倍体)基因组上的等位基因(或者杂合位点),按照其亲本正确地定位到父亲或者母亲的染色体上,最终使得所有来自同一个亲本的等位基因都能够排列在同一条染色体里面。

现在流行的NGS测序技术,都是把序列打乱混在一起测序的,测完之后,我们是无法直接区分这些序列中哪一个是父源,哪一个是母源的。我们通常都只是检测出基因组上有哪些变异,以及这些变异的碱基组成(纯合、杂合),也就是平时所说的基因型(Genotype)。只有经过Phasing,才能够实现这个区分。

为什么要Phasing ?

因为Phasing很重要。Phasing的重要性可以分为两个方面。

一方面, Phasing与遗传变异的功能诠释密切相关。这体现在遗传咨询师或者科学家需了解基因突变的相位后, 才能更好地判断基因突变是否会产生临床表型。比如在一个基因上发生多个Loss of function variants(LOF),通常当这些变异出于不同的单倍型时(这称为trans-configuration),即两个拷贝的姐妹基因都发生了变异, 才会导致基因表达计量(Gene expression dosage)的错误且产生危害。而当它们出于同一个单倍型时(这称为cis-configuration),因为还有一个正常拷贝的基因(作为备胎), 基因表达很可能不会发生改变也不会产生危害。

另一方面, Phasing在遗传学研究中也有诸多应用,具体如下:

- 第一、人群Phasing后形成的单倍型参考序列集(Reference panel)是基因型推断(Imputation)必须的数据材料。而基因型推断(Imputation)是基因型-表型关联分析研究中必不可少的环节。高质量的Reference Panel能提升关联分析的统计功效;

- 第二、除了Reference Panel的制造需要使用Phasing技术之外,对被研究的对象进行预先Phasing(Pre-phasing)也可以极大地提高基因型推断(Imputation)的准确性;

- 第三、使用多个位点组成的Haplotype,而不是简单的单位点基因型, 可实现群体遗传历史的推断;

- 第四、可通过Phased后的家系人群单倍型序列,估算染色体重组率、重组热点等重要遗传参数;

- 第五、Phasing可用于探测频发突变、选择信号以及基因表达的顺势调控。

Phasing说起来容易,做起来却很难

虽然Phasing理解起来并不难,但实现起来却不容易,即使在理论上也是如此。这需要相关的统计学和计算机算法技术,求解的过程往往还是一个NP问题。目前通常采用马尔科夫链蒙特卡洛算法来完成,因此,Phasing算法本身基本都是计算密集型的,做起来也比较耗时间,有时即使是在超算集群中也得跑很长时间。

https://github.com/bluenote-1577/flopp

alevin-fry: 高效灵活的单细胞测序数据处理工具

alevin-fry是一套工具,用于快速、准确和节省内存地处理单细胞和单核测序数据。

该套工具是马里兰大学计算生物学和网络进化实验室开源的。该实验室的 GitHub 组织下还有其他的计算生物学相关的 Rust 库。

背景 单细胞测序技术将伴随着高通量技术给临床以及学术界带来新的革命。理解单细胞水平的遗传信息异质性,为我们理解遗传、发育、疾病机理打开了新的大门。 参考: https://www.plob.org/article/22832.html

https://github.com/COMBINE-lab/alevin-fry

其他

用 Rust 和 WASM 重建世界上最短的数学论文

1769年,欧拉提出了欧拉猜想(sum of powers)。1966 年,L. J. Lander 和 T. R. Parkin 用他们使用 CDC 6600 大型计算机发现的反例反驳了这个猜想。 众所周知,他们的论文只包含两句话。

2022年,你用在手机上的浏览器,就可在2秒左右找到他们的反例,以及更多反例。

可以通过该网页 https://carlkcarlk.github.io/shortestpaper/ 亲自尝试。 该页面使用 Rust 和 WASM。

开源观察 | 其他工具

lapce 发布 0.0.9 版本

lapce 是一款受 Xi-Editor 启发的编辑器,类似于 vscode。作者声称,他对 lapce 抱有雄心壮志,希望有朝一日可以和 VScode 竞争。

目标:

- 启动迅速,基于 Rust + Druid 开发,使用 wgpu 渲染。

- 支持远程开发

- 支持 LSP,支持代码智能提示、诊断等

- Vim 模式支持

- WASI 插件系统

- 内置终端

目前为 0.0.9 版本,看起来还不太完善,可以先关注。

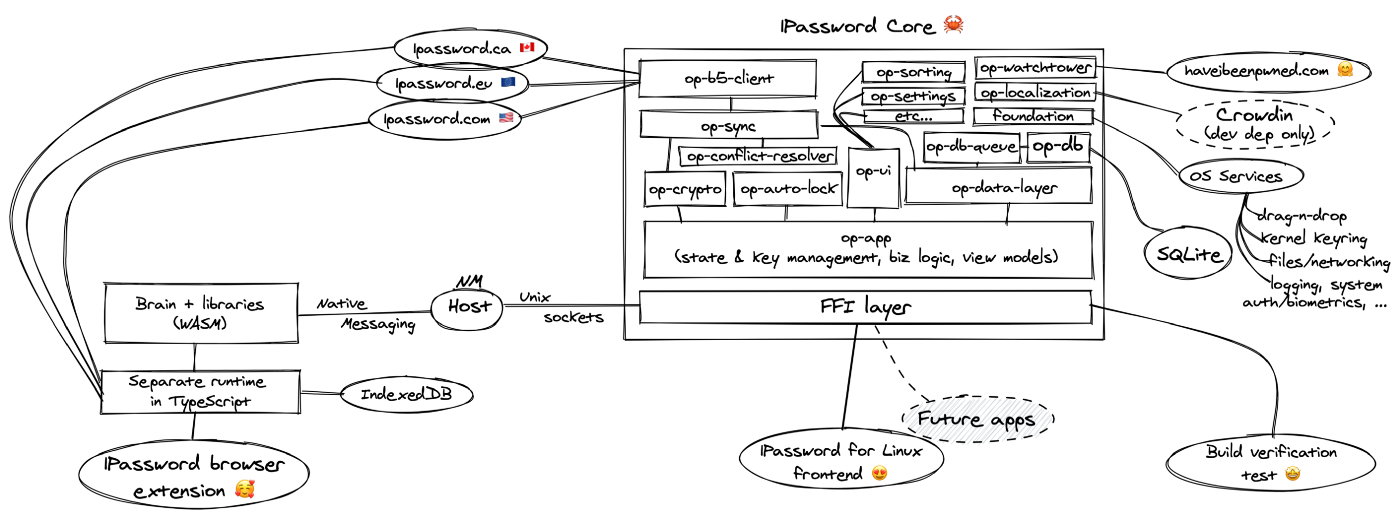

arboard: 1Password 开源的跨平台剪切板工具

支持在 Linux、Mac 和 Windows 上以独立于平台的方式复制和粘贴文本和图像数据。

https://github.com/1Password/arboard

sys-locale: 1Password 开源的轻量级获取位置的跨平台库

支持 iOS/ Android/ MacOS/ Linux/ Windows/ WebAssembly 等平台。

https://github.com/1Password/sys-locale

Weylus:移动设备作为输入板/触屏

将平板电脑或智能手机用作计算机上的图形输入板 / 触摸屏。

主要特征:

- 使用平板电脑控制鼠标

- 将屏幕镜像到平板电脑

- 使用物理键盘发送键盘输入

- 硬件加速视频编码

上述功能在所有操作系统上都可用,但 Weylus 在 Linux 上效果最好。

Linux 上的其他功能包括:

- 支持手写笔 / 笔(支持压力和倾斜)

- 多点触控:尝试使用支持多点触控的软件,如 Krita

- 捕获特定窗口并仅绘制到它们

- 更快的屏幕镜像

- 平板电脑作为第二个屏幕

https://github.com/H-M-H/Weylus

ProjClean: 查找和清理 build 和 cache 目录

ProjClean 会为你找到 node_modules(node)、target(rust)、build(java)等目录及其存储空间,所以你可以很容易地检查或清理。

https://github.com/sigoden/projclean

Zine - 简单易用的个人杂志生成器

-

移动设备优先。

-

直观而优雅的杂志设计。

-

最佳的阅读体验。

-

主题可定制,扩展友好。

-

支持 RSS Feed 。

-

支持开放图谱协议(Open Graph Protocol)。

-

建立静态网站,托管在任何地方。

-

《TO-D 杂志》- 由 Zine 驱动: https://github.com/zineland/2d2d

跨平台文件搜索引擎:orange

https://github.com/naaive/orange

安全动态

记录 Rust 生态中的安全问题,来自 RustSec 和 GitHub 公告。

分类:

CVE-2022-21658: Rust 标准库中存在竞争条件可以允许攻击者删除他们无权删除的文件

Rust 安全响应工作组被通知std::fs::remove_dir_all 标准库函数容易受到启用符号链接跟踪的竞争条件 (CWE-363) 的影响。攻击者可以利用此安全问题诱使特权程序删除攻击者无法访问或删除的文件和目录。

https://blog.rust-lang.org/2022/01/20/cve-2022-21658.html

CVE-2022-24713: regex crate 存在 DoS 漏洞

因为 regex crate 没有正确限制它解析的正则表达式 (regex) 的复杂性,攻击者可以使用此安全问题执行拒绝服务,方法是向接受不受信任的正则表达式的服务发送特制的正则表达式。使用受信任的正则表达式解析不受信任的输入时,不存在已知漏洞。

1.5.4 之前或等于 1.5.4 的所有版本的regex crate 都会受到此问题的影响。修复包括从 regex1.5.5 开始。

https://blog.rust-lang.org/2022/03/08/cve-2022-24713.html

Unsound

RUSTSEC-2022-0007: qcell crate 中 TCell 或 TLCell 的内存能被恶意代码访问

因为生命周期参数型变未使用正确而引起的问题,导致恶意代码可以对同一片内存获取两个可变引用。解决方法是把类型参数的协变(Covariant)改为不变(Invariant)。

#![allow(unused)] fn main() { struct Invariant<T>(fn(T) -> T); pub struct TCellOwner<Q: 'static> { // Allow Send and Sync, and Q is invariant typ: PhantomData<Invariant<Q>>, } pub struct TCell<Q, T: ?Sized> { // use Invariant<Q> for invariant parameter, not influencing // other auto-traits, e.g. UnwindSafe (unlike other solutions like `*mut Q` or `Cell<Q>`) owner: PhantomData<Invariant<Q>>, // It's fine to Send a TCell to a different thread if the containted // type is Send, because you can only send something if nothing // borrows it, so nothing can be accessing its contents. // // `UnsafeCell` disables `Sync` and already gives the right `Send` implementation. // `Sync` is re-enabled below under certain conditions. value: UnsafeCell<T>, } }

RUSTSEC-2022-0010:Enum错误实现 trait时 enum_map 宏可能会导致 UB

enum_map!受影响版本在使用宏时未正确检查枚举的长度,信任用户提供的长度。

当Enum trait 中的 LENGTH 与 EnumArray trait 中的数组长度不匹配 时,可能会导致枚举映射初始化为未初始化的类型,进而允许攻击者执行任意代码。

这个问题只能在手动实现 Enum trait 时发生,它永远不会发生在使用#[derive(Enum)].

触发此漏洞的示例代码如下所示:

#![allow(unused)] fn main() { enum E { A, B, C, } impl Enum for E { // LENGTH 长度不等于 EnumArray 长度 const LENGTH: usize = 2; fn from_usize(value: usize) -> E { match value { 0 => E::A, 1 => E::B, 2 => E::C, _ => unimplemented!(), } } fn into_usize(self) -> usize { self as usize } } impl<V> EnumArray<V> for E { type Array = [V; 3]; } let _map: EnumMap<E, String> = enum_map! { _ => "Hello, world!".into() }; }

- https://rustsec.org/advisories/RUSTSEC-2022-0010.html

- https://gitlab.com/KonradBorowski/enum-map/-/blob/master/CHANGELOG.md#version-202

Rust 安全参考 | 内存相关漏洞

RUSTSEC-2022-0002: dashmap 中的引用出现 UAF

由Ref(和类似类型)的一些方法返回的引用可能会超过Ref并逃脱锁。这将导致未定义的行为,并可能导致一个段错误。

- https://rustsec.org/advisories/RUSTSEC-2022-0002.html

- https://github.com/xacrimon/dashmap/issues/167

RUSTSEC-2022-0008: Windows-rs 中 Delegate 函数缺乏 Send 限定

- https://rustsec.org/advisories/RUSTSEC-2022-0008.html

- https://github.com/microsoft/windows-rs/issues/1409

RUSTSEC-2022-0012: Arrow2 在 Safe 代码中出现双重释放(double-free)

Ffi_ArrowArray 结构体错误实现 #derive(Clone) ,因为它是一个 FFi 绑定,实现 Clone 会导致出现两份指针,从而导致双重释放。

- https://github.com/jorgecarleitao/arrow2/issues/880

- https://rustsec.org/advisories/RUSTSEC-2022-0012.html

RUSTSEC-2022-0003: ammonia 中存在格式化注入漏洞

clean_text中错误映射 HTML 的 Form Feed,导致注入漏洞。

#![allow(unused)] fn main() { let html = format!("<div title={}>", clean_text(user_supplied_string)); }

RUSTSEC-2022-0006: thread_local crate 中的 RawIter::next 存在数据竞争

主要是因为内存顺序指定错误而引起的,解决起来也比较简单,修改为正确的内存顺序即可。

- https://rustsec.org/advisories/RUSTSEC-2022-0006.html

- https://github.com/Amanieu/thread_local-rs/issues/33

RUSTSEC-2022-0016: wasmtime 的 externref 在启用 epoch 中断时会导致 UAF

epoch 中断会导致 wasmtime 在执行 GC 时错误回收还在使用的内存,从而导致 UAF。

- https://github.com/bytecodealliance/wasmtime/security/advisories/GHSA-gwc9-348x-qwv2

- https://rustsec.org/advisories/RUSTSEC-2022-0016.html

Rust 安全参考 | 内存相关漏洞

RUSTSEC-2022-0002: dashmap 中的引用出现 UAF

由Ref(和类似类型)的一些方法返回的引用可能会超过Ref并逃脱锁。这将导致未定义的行为,并可能导致一个段错误。

- https://rustsec.org/advisories/RUSTSEC-2022-0002.html

- https://github.com/xacrimon/dashmap/issues/167

RUSTSEC-2022-0008: Windows-rs 中 Delegate 函数缺乏 Send 限定

- https://rustsec.org/advisories/RUSTSEC-2022-0008.html

- https://github.com/microsoft/windows-rs/issues/1409

RUSTSEC-2022-0012: Arrow2 在 Safe 代码中出现双重释放(double-free)

Ffi_ArrowArray 结构体错误实现 #derive(Clone) ,因为它是一个 FFi 绑定,实现 Clone 会导致出现两份指针,从而导致双重释放。

- https://github.com/jorgecarleitao/arrow2/issues/880

- https://rustsec.org/advisories/RUSTSEC-2022-0012.html

RUSTSEC-2022-0003: ammonia 中存在格式化注入漏洞

clean_text中错误映射 HTML 的 Form Feed,导致注入漏洞。

#![allow(unused)] fn main() { let html = format!("<div title={}>", clean_text(user_supplied_string)); }

RUSTSEC-2022-0006: thread_local crate 中的 RawIter::next 存在数据竞争

主要是因为内存顺序指定错误而引起的,解决起来也比较简单,修改为正确的内存顺序即可。

- https://rustsec.org/advisories/RUSTSEC-2022-0006.html

- https://github.com/Amanieu/thread_local-rs/issues/33

RUSTSEC-2022-0016: wasmtime 的 externref 在启用 epoch 中断时会导致 UAF

epoch 中断会导致 wasmtime 在执行 GC 时错误回收还在使用的内存,从而导致 UAF。

- https://github.com/bytecodealliance/wasmtime/security/advisories/GHSA-gwc9-348x-qwv2

- https://rustsec.org/advisories/RUSTSEC-2022-0016.html

Rust 安全参考 | 其他类型

Rust 编译到 WebAssembly 可能出现的侧信道攻击

这是一篇来自 Trail of Bits 安全公司博客的文章,介绍了 Rust 利用 LLVM 编译到 WebAssembly 时可能出现新的侧信道攻击风险。

许多工程师选择 Rust 作为他们实现加密协议的首选语言,因为它具有强大的安全保证。尽管 Rust 使安全的密码工程更容易,但仍有一些挑战需要注意。其中之一是需要保留恒定时间(constant-time)属性,这确保无论输入如何,代码都将始终花费相同的时间来运行。这些属性在防止时序攻击(timing attack)方面很重要,但它们可能会受到编译器优化的影响。

时序攻击,是侧信道攻击时序攻击属于侧信道攻击/旁路攻击(Side Channel Attack),侧信道攻击是指利用信道外的信息,比如加解密的速度/加解密时芯片引脚的电压/密文传输的流量和途径等进行攻击的方式,一个词形容就是“旁敲侧击”。举一个最简单的计时攻击的例子,某个函数负责比较用户输入的密码和存放在系统内密码是否相同,如果该函数是从第一位开始比较,发现不同就立即返回,那么通过计算返回的速度就知道了大概是哪一位开始不同的,这样就实现了电影中经常出现的按位破解密码的场景。密码破解复杂度成千上万倍甚至百万千万倍的下降。最简单的防御方法是:“发现错误的时候并不立即返回,而是设一个标志位,直到完全比较完两个字符串再返回”。 来源知乎:https://www.zhihu.com/question/20156213/answer/43377769

恒定时间(constant-time)

密码学很难正确实现。除了担心整体正确性和可能以意想不到的方式暴露秘密的边缘情况外,潜在的侧信道泄漏和时序攻击也是令人深感担忧的问题。

时序攻击试图利用应用程序的执行时间可能微妙地依赖于输入这一事实。如果应用程序根据私密数据(例如随机数生成器或私钥的种子)做出与控制流相关的决策,这可能会稍微影响应用程序的执行时间。同样,如果使用私密数据来确定从内存中的哪个位置读取,这可能会导致缓存未命中,进而影响应用程序的执行时间。在这两种情况下,有关私密数据的信息都会在程序执行期间通过时间差异泄露。

为了防止这种时间差异,密码学工程师通常避免根据私密数据实施决策。但是,在代码需要根据私密数据做出决策的情况下,有一些巧妙的方法可以在恒定时间内实现它们,也就是说,无论输入如何,总是在相同的时间内执行。例如,考虑以下Rust函数,它在变量a和 b之间执行条件选择。

#![allow(unused)] fn main() { #[inline] fn conditional_select(a: u32, b: u32, choice: bool) -> u32 { if choice { a } else { b } } }

根据编译器工具链和目标指令集的不同,编译器可以选择使用分支指令来实现条件选择,比如x86上的jne或ARM上的bne。这将在函数的执行过程中引入一个时间差,这可能会泄露关于选择变量的信息。下面的Rust实现使用了一个巧妙的技巧,在恒定时间内执行相同的条件选择。

#![allow(unused)] fn main() { // 设置标志位,避免马上返回 #[inline] fn conditional_select(a: u32, b: u32, choice: u8) -> u32 { // if choice = 0, mask = (-0) = 0000...0000 // if choice = 1, mask = (-1) = 1111...1111 let mask = -(choice as i32) as u32; b ^ (mask & (a ^ b)) } }